Simulare la vita

Dallo studio al computer degli organismi ai tentativi di sintesi di nuove forme di vita, breve storia dell'Artificial Life.

Dallo studio al computer degli organismi ai tentativi di sintesi di nuove forme di vita, breve storia dell'Artificial Life.

N el 1943 il fisico Erwin Schrödinger scelse Che cos’è la vita? come titolo di un ciclo di conferenze da tenere a Dublino. Era una domanda che l’ossessionava da sempre: dopo aver contribuito in modo decisivo allo sviluppo della fisica quantistica, riteneva giunto il momento di provare a offrire un contributo sull’argomento.

Il suo ragionamento era semplice: la vita è, essenzialmente, informazione. Più precisamente, la vita è caratterizzata dalla trasmissione delle informazioni da un organismo a un altro per mezzo della riproduzione. Schrödinger intuì che la cellula uovo doveva possedere “un elaborato codice che riguarda tutto il futuro sviluppo dell’organismo” con un numero di atomi piccolo, poiché anche pochi elementi sarebbero stati sufficienti a creare un enorme numero di combinazioni.

La scoperta del codice genetico, basato sulle quattro basi dei nucleotidi (G, A, T, C), avrebbe confermato di lì a poco la sua intuizione. Schrödinger aveva però immaginato il gene in maniera diversa, come una sorta di cristallo aperiodico che può disporre i suoi atomi in configurazioni sempre diverse. Così, il testo che raccoglieva le sue conferenze sul tema venne presto considerato superato. Oggi quel testo ha assunto però una nuova centralità nella comprensione di uno dei più fortunati paradigmi dello studio della vita: quello basato sulla teoria dell’informazione.

La teoria dell’informazione promette di riuscire a simulare la vita al computer, e di poter creare nuove forme di vita artificiali. Nelle sue versioni estreme, come il programma di ricerca lanciato alla fine degli anni Ottanta dal fisico teorico John A. Wheeler con il famoso slogan It from Bit, la teoria dell’informazione potrebbe rivelarsi una sorta di “teoria del tutto” in grado di svelarci la reale struttura dell’universo.

La teoria dell’informazione promette di riuscire a simulare la vita al computer, e di poter creare nuove forme di vita artificiali.

Il concetto così quotidiano ma al tempo stesso così esoterico di informazione è stato trasformato in entità fisica da Claude Shannon, ingegnere e matematico, nel 1948, nel suo articolo A Mathematical Theory of Communication, una teoria matematica della comunicazione. Secondo Shannon, è possibile misurare la quantità d’informazione contenuta in qualsiasi oggetto – dal microchip alla cellula vivente, da un libro all’intero universo – attraverso la sua unità minima, il bit.

Negli scorsi decenni intere branche della fisica – per esempio la termodinamica – sono state ridefinite in termini di teoria dell’informazione; e ancor più recentemente, riprendendo a distanza l’intuizione di Schrödinger, ci si è spinti a una teoria dell’informazione biologica in grado di spiegare la vita stessa. Una recente teoria proposta dai matematici David Wolpert e Artemy Kolchinsky, implicherebbe che “la vita possa essere considerata come un processo di computazione che punta a ottimizzare lo stoccaggio e l’utilizzo di informazione dotata di senso”. Secondo Wolpert e Kolchinsky, l’adattamento di un sistema vivente all’ambiente dipenderebbe dalla sua capacità di estrarre informazione dall’ambiente; organismi con scarso adattamento non riescono a estrarre sufficiente informazione (in forma di energia) per ridurre l’aumento della loro entropia, e sono destinati a morire rapidamente. Per Christopher Adami, che insegna microbiologia, genetica molecolare e fisica alla Michigan State University, “l’informazione è la ‘valuta’ della vita”, ossia l’unità di scambio tra sistemi viventi.

Oggi la Artificial Life o, nella forma abbreviata, ALife, è una disciplina di ricerca popolare. Si distingue in due branche, o approcci: quello “debole” ha per obiettivo l’impiego di simulazioni informatiche per studiare i processi di genesi ed evoluzione della vita come la conosciamo, mentre quello “forte” utilizza le simulazioni informatiche per sintetizzare nuove forme di vita artificiale diverse da quelle che esistono in natura. La prima studia quindi la vita come la conosciamo, l’altra si occupa della vita come potrebbe essere: su altri pianeti, in altre galassie, o anche nei computer, sulla base dell’ipotesi che, a determinate condizioni, algoritmi appositamente programmati possano diventare autonomi, riprodursi e acquisire una qualche sorta di consapevolezza. Diventare, insomma, “vivi”. Secondo il biologo americano Thomas Ray, affinché si possa parlare di vita artificiale essa deve rivelarsi in grado di “auto-replicarsi, ed evolvere in strutture o processi che non sono stati pre-programmati o concepiti a priori dal creatore”.

Primi tentativi

La ricerca di modelli matematici utili allo studio della vita è una delle sfide dell’era informatica fin dai suoi albori. Lo stesso Shannon, prima di approdare allo studio delle telecomunicazioni, applicò per la prima volta metodi matematici allo studio della genetica delle popolazioni, un tema verso il quale era stato spinto da Vannevar Bush, suo tutor di dottorato, ingegnere e inventore che aveva avuto un ruolo determinante nello sviluppo dei calcolatori.

Nel 1948 Norbert Wiener, uno degli insegnanti di Shannon al MIT, coniò il concetto di cibernetica, nuova disciplina tesa allo studio dei “processi di controllo e comunicazione negli animali e nelle macchine”. Secondo Wiener, la teoria dell’informazione poteva essere applicata alla comprensione dei meccanismi tanto dei calcolatori che degli esseri viventi, tenendo conto del ruolo che in entrambi gioca il concetto di feedback, cioè la capacità di autoregolarsi e adattarsi all’ambiente: in base al feedback che si riceve dall’ambiente esterno, la macchina e l’animale modificano di conseguenza i loro processi.

Secondo Wiener, la teoria dell’informazione poteva essere applicata alla comprensione dei meccanismi tanto dei calcolatori che degli esseri viventi.

Verso la fine della sua vita, anche Alan Turing iniziò ad applicare la teoria dell’informazione alla biologia. Turing era stato sempre attratto dall’embriologia e dal problema di come fosse possibile passare da una singola cellula a un organismo complesso, ossia “come sia possibile che l’informazione contenuta nei geni possa tradursi in azione”. Per rispondere a questa domanda, si servì del calcolatore Mark I all’Università di Manchester, sviluppando un modello matematico semplificato delle cellule di un’idra (il suo scopo era quello di provare l’ipotesi dell’esistenza di campi morfogenetici, sorta di “istruzioni” trasmesse alle cellule vicine per indurle a seguire un particolare schema morfologico). Il suo suicidio, di lì a poco, avrebbe lasciato le sue ricerche allo stadio embrionale di appunti poco comprensibili.

Anche John Von Neumann, altro pioniere dell’informatica e della meccanica quantistica, fu attratto, nei suoi ultimi anni, dallo studio della vita attraverso i calcolatori. Con l’arrivo di un supercomputer all’Institute for Advanced Study di Princeton, von Neumann pensò di dedicarsi allo studio degli automi autoreplicanti, algoritmi in grado di replicare se stessi in modo casuale simulando i meccanismi di riproduzione degli esseri viventi. “Ho ragionato parecchio sui meccanismi autoreplicanti. Sono in grado di formulare il problema in termini rigorosi, [così come] ha fatto Turing per i suoi meccanismi”, scrisse nel novembre 1946 a Norbert Wiener. Ma, anche in questo caso, la morte impedì a von Neumann di realizzare il suo progetto. Rimase solo sulla carta, sotto forma di appunti sparsi che vennero infine sistemati e pubblicati nel 1966 con il titolo Theory of Self-Reproducing Automata.

Codici e primi esperimenti

L’utilizzo del paradigma informazionale in biologia si è rivelato fecondo soprattutto a partire dalla scoperta del “codice genetico” da parte di Watson e Crick. Il concetto stesso di codice genetico rimanda alla metafora del codice informatico e suggerisce l’idea che lo sviluppo di un organismo sia in ultima istanza il risultato dell’esecuzione di un “codice sorgente” inscritto nel DNA.

Nel loro libro Una visione della vita, Stephen J. Gould, Salvador E. Luria e Sam Singer scrivono: “Come un programma per il calcolatore specifica le operazioni che esso deve svolgere, così il DNA nelle cellule di un organismo specifica il funzionamento di quell’organismo”. Nel suo best-seller L’orologiaio cieco Richard Dawkins popolarizza la metafora del DNA come supporto di memoria: “Fuori sta piovendo DNA”, scrive. “Stanno piovendo istruzioni là fuori; stanno piovendo programmi; stanno piovendo algoritmi contenenti istruzioni sulla crescita degli alberi, sulla propagazione di semi contenuti in soffici batuffoli di cotone. Non è una metafora, è la pura verità. La cosa non potrebbe essere più evidente se stessero piovendo dei floppy disk”. All’epoca in cui Dawkins scriveva queste righe, i floppy disk erano i supporti di memorizzazione digitale più utilizzati. Il paragone tuttavia è limitante, perché, rispetto ai floppy disk, il DNA ha una capacità di stoccaggio d’informazione enorme. Oggi sappiamo che può contenere informazione con una densità per unità di volume superiore a qualsiasi altro supporto conosciuto, fino a un quarto della densità massima d’informazione consentita dalle leggi della fisica (data dall’entropia dei buchi neri). Si stima sia possibile archiviare tutti i dati digitali del mondo in una quantità di DNA non superiore al peso di otto graffette.

È chiaro come tutto ciò abbia sollecitato l’immaginazione di coloro che hanno iniziato a studiare la possibilità di replicare questo meccanismo all’interno dei computer, spingendo la metafora dell’informazione fino al punto da trasformarla in un autentico programma di ricerca per creare nuove forme di vita artificiali.

Il primo vero esperimento risale agli studi pionieristici e dimenticati del fisico e matematico Nils Aall Barricelli nel 1953, riscoperti solo in anni recenti dallo scrittore e storico della scienza George Dyson. Ricercatore all’Università di Oslo, Barricelli – che aveva madre norvegese e padre italiano e aveva studiato a Roma con Fermi – si dedicò alla genetica e allo studio dei virus attraverso modelli matematici, sviluppati per cercare di dimostrare la sua teoria della simbiogenesi, secondo cui la selezione naturale favorisce la collaborazione, quindi la “simbiosi” tra geni.

La sua speranza era di replicare al computer un meccanismo di evoluzione della specie simile a quello reale, così da dimostrare la validità della sua proposta. Dopo qualche anno, tuttavia, dovette gettare la spugna: “Per quante mutazioni facciamo, i numeri resteranno sempre numeri. Non diventeranno mai organismi viventi!”.

L’utilizzo del paradigma informazionale in biologia si è rivelato fecondo soprattutto a partire dalla scoperta del “codice genetico” da parte di Watson e Crick.

Col tempo, tuttavia, Barricelli iniziò a chiedersi se i suoi simbio-organismi non si potessero considerare, invece che modelli approssimati di qualcosa di esistente sulla Terra, delle forme di vita nuove: “Non sono modelli: non più di quanto possano essere definiti modelli gli organismi viventi. Sono una categoria particolare di strutture autoreplicanti già definite”. Nel suo ultimo articolo, del 1987, suggerì un parallelismo tra l’intelligenza naturale e quella artificiale, intesi come fenomeni collettivi. “Solo il futuro potrà dirci se esistono modi per comunicare con i cervelli genetici di simbio-organismi diversi, magari usando il loro linguaggio genetico”.

Un’idea del genere è balzata alla mente di Richard Dawkins con il programma da lui sviluppato per studiare l’evoluzione della vita, “Biomorph”. Come spiega nel suo L’orologiaio cieco, Dawkins si aspettava che il software producesse non più di complicate forme ad albero in grado di simulare i processi evolutivi: “Nulla nella mia intuizione di biologo, nulla nella mia esperienza ventennale di programmatore di computer e nulla nei miei sogni più sfrenati mi preparava a ciò che comparve in realtà sullo schermo. Posso ricordare esattamente quando, nella sequenza delle generazioni, cominciò a balenarmi per la prima volta la possibilità che tale evoluzione potesse produrre qualcosa di simile a un insetto”.

Gradualmente, Dawkins seleziona, generazione per generazione, gli output più favorevoli, fino a produrre biomorfi dotati di otto zampe come i ragni: “Udii distintamente nella mia testa le trionfali note iniziali del poema sinfonico Also sprach Zarathustra (il tema di 2001 Odissea nello spazio). Non riuscii a mangiare, e quella notte i miei insetti sciamavano dietro le mie palpebre mentre tentavo invano di dormire”. Come Barricelli, Dawkins iniziava ad attribuire alle sue creature digitali una parvenza di vita.

I giochi della vita

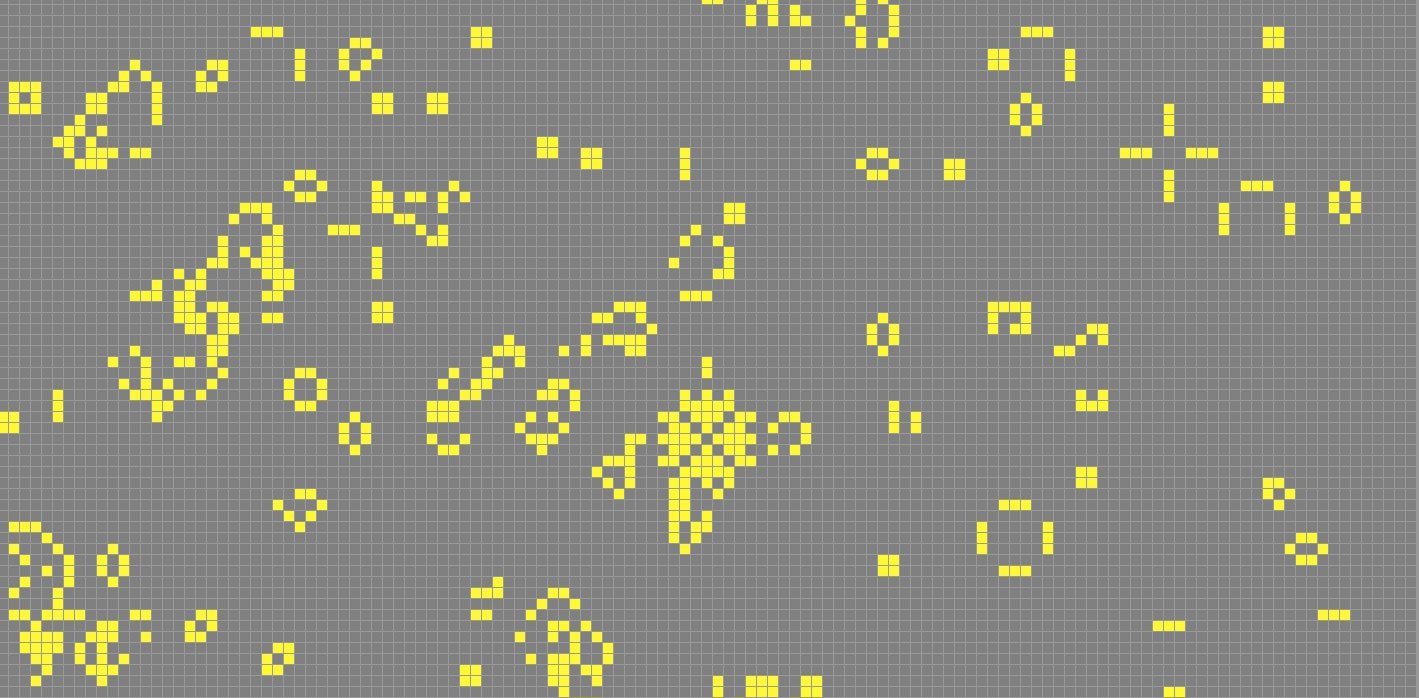

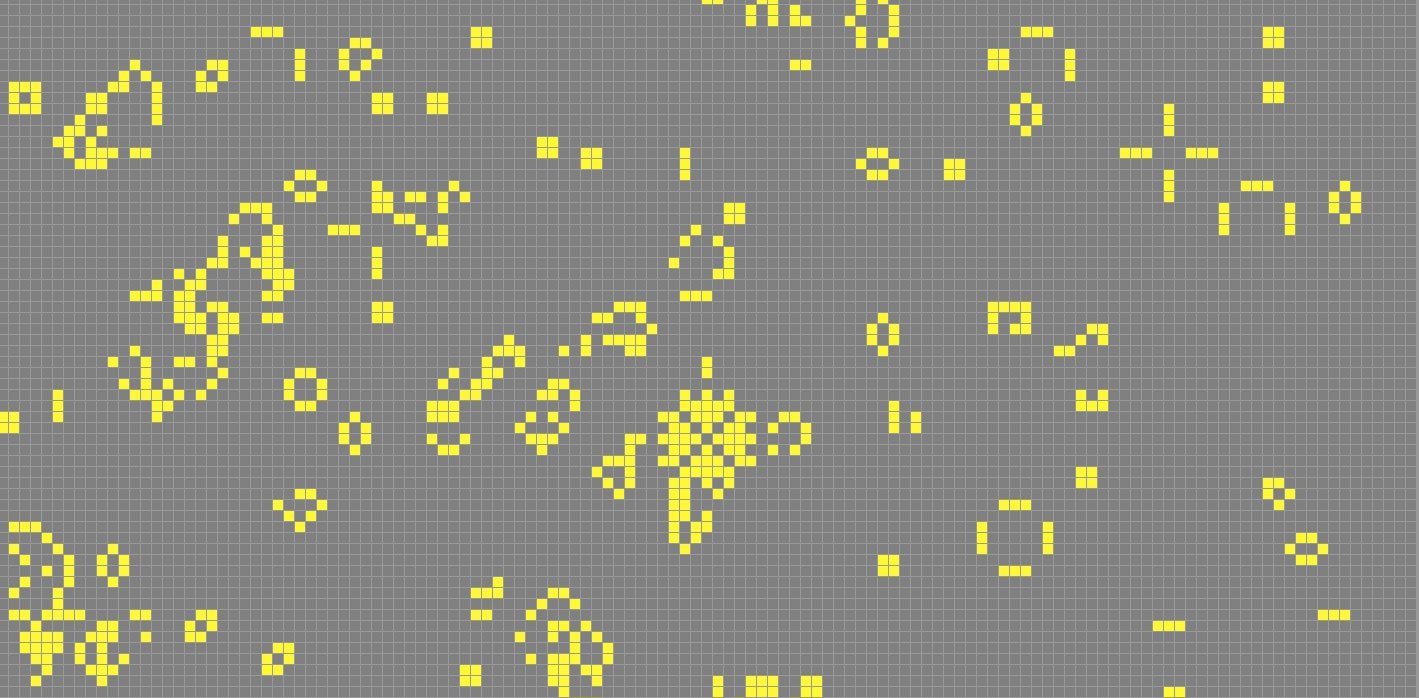

Uno dei primi programmi considerati alla base dell’ALife è il celebre “Gioco della Vita” del matematico John Conway, che riprese le idee degli automi di von Neumann sviluppando un mondo virtuale basato su griglie che disegnano delle celle e in cui ogni cella può essere “accesa” (ossia viva) o “spenta” (vale a dire morta), e la sua evoluzione dipende dalle celle immediatamente limitrofe: se una cella viva è affiancata da due o tre celle vive, allora sopravvive alla generazione successiva, mentre muore se le celle limitrofe vive sono di meno (per “isolamento”) o sono più di tre (per “sovrappopolazione”), mentre una cellula morta con tre celle vive adiacenti torna in vita (non per resurrezione, ma simulando la “riproduzione”).

Da queste semplici regole emergono, nel corso delle generazioni, situazioni del tutto originali, pattern specifici, configurazioni periodiche che rendono la “vita” sempre più complessa. Il “Gioco della Vita” di Conway ha ricevuto un’enorme attenzione, venendo giocato (ossia fatto girare sui PC) da milioni di utenti in tutto il mondo, che negli anni hanno creato comunità di discussione e prodotto persino articoli scientifici.

Non meraviglia, dunque, che nel tempo siano stati messi in commercio veri e propri videogames dedicati alla vita artificiale, da SimLife a Creatures, fino al più recente Spore. Grazie agli sviluppi della computer-grafica, negli ultimi decenni sono emersi nuovi software di simulazione per la vita artificiale, impiegati nella ricerca scientifica ma con molte affinità con i videogames. I più impiegati ancora oggi sono “PolyWorld” e “Tierra”, i cui primi sviluppi risalgono, per entrambi, alla prima metà degli anni Novanta.

Uno dei primi programmi considerati alla base dell’ALife è il “Gioco della Vita” del matematico Conway, che sviluppa un mondo virtuale basato su griglie in cui ogni cella può essere “accesa” o “spenta”.

“Tierra”, sviluppato dal già citato Thomas Ray, che si è evoluto poi in una versione che gira su Internet e non solo all’interno di un unico calcolatore, si avvale di algoritmi genetici che si riproducono e mutano, proprietà che Ray ritiene essere gli elementi basilari della vita. La sua descrizione del funzionamento di “Tierra” è particolarmente interessante, perché sviluppa tutta una serie di parallelismi tra i meccanismi artificiali del programma e le funzioni biologiche:

“In Tierra, le entità che si autoreplicano sono programmi eseguibili in linguaggio macchina; essi non fanno altro che ricopiare sé stessi nella memoria RAM dell’elaboratore. Pertanto, il codice in linguaggio macchina rappresenta l’analogo del codice genetico della vita organica, basato sugli acidi nucleici. La replicazione dei programmi è realizzata mediante la loro esecuzione da parte della cpu. Pertanto, il tempo dedicato dalla cpu alla loro elaborazione è l’analogo dell’energia che guida il metabolismo. I programmi in linguaggio macchina occupano spazio nella memoria RAM, quindi essa rappresenta l’analogo dello spazio fisico per la vita organica”.

Nuova scienza, nuovi critici

Nel 2002 apparve negli Stati Uniti un libro destinato a suscitare un vivo dibattito nella comunità scientifica, soprattutto tra chi si occupava di vita artificiale: A New Kind of Science di Stephen Wolfram. Ex fisico teorico poi convertitosi all’informatica e all’imprenditoria, Wolfram aveva studiato gli automi cellulari di von Neumann all’Institute for Advanced Study negli anni Ottanta, sviluppando un linguaggio informatico in grado di farli evolvere a livelli di complessità allora inimmaginabili, superando i limiti del “Gioco della vita” di Conway.

La classe di automi cellulari del gioco di Conway è definita da Wolfram “Classe 1”, basata su un set di regole molto limitato. Da qui, Wolfram sviluppò altre tre classi di complessità crescente, con un numero di regole maggiore ma sempre limitato, in grado di dar vita a forme complesse e regolari, come i frattali, attraverso evoluzioni puramente casuali. Con la Classe 4 dei suoi automi cellulari, Wolfram osservò l’emergere di strutture complesse che non si ripetevano, ciascuna diversa dalle altre. Secondo Wolfram, la Classe 4 è considerabile “computazionalmente equivalente” alle strutture complesse che osserviamo nel mondo reale, inclusi gli esseri viventi come noi.

Non tutti sono convinti che l’intero universo possa essere ricondotto a processi di computazione simulabili al computer. Secondo Ray Kurzweil, tecnologo e futurologo attivo in settori simili a quelli di Wolfram, nella Classe 4 gli automi cellulari non sono in grado di dar vita a intelligenze artificiali nemmeno equivalenti all’intelligenza di un verme.

Non tutti sono convinti che l’intero universo possa essere ricondotto a processi di computazione simulabili al computer.

Per i critici del paradigma informazionale, come il biologo e studioso della complessità Brian Goodwin, per quanto “le metafore di tipo informazionale e computeristico siano state estremamente utili e abbiano aiutato a organizzare concettualmente il gran numero di particolari di ordine molecolare che sono stati messi in evidenza negli ultimi due decenni”, si sono però rivelate incapaci “di fornire una teoria morfogenetica adeguata”. Lo studioso contesta in particolare il concetto di “programma genetico” perché non riesce a dare conto del passaggio-chiave dall’informazione contenuta nei geni alla forma biologica macroscopica. Sostenere che la vita è essenzialmente informazione codificata ed espressa dai geni non fornisce maggiore potere esplicativo, secondo lui, “di quello che si avrebbe spiegando il campo magnetico della Terra dicendo che il pianeta possiede un nucleo liquido di ferro-nichel. In entrambi i casi le asserzioni sono vere e descrivono le condizioni necessarie dei fenomeni: senza proteine non si avrebbe morfologia; senza ferro-nichel non si avrebbe il magnetismo terrestre. Ma esse fanno riferimento a una domanda sbagliata, giacché suggeriscono che ciò che importa sia la composizione. Il problema è invece di comprendere in che modo la proteina o il ferro-nichel siano organizzati dinamicamente e strutturalmente nell’ambito di dimensioni caratteristiche, in maniera tale che possano prodursi le specifiche proprietà prese in considerazione”.

Christopher Langton, considerato il padre dell’ALife, enfatizza quest’aspetto: “La vita è una proprietà della forma, non della materia, il risultato dell’organizzazione della materia piuttosto che qualcosa presente nella materia stessa”. Gli esponenti più entusiasti di questo tipo di studi, come Wolfram o Dawkins, ritengono di essere riusciti a replicare questa organizzazione nei loro ambienti simulati; altri, come Kurzweil, frenano, sostenendo che, in mancanza di una vera forma di intelligenza artificiale all’interno degli automi cellulari, l’obiettivo sia ben lontano dall’essere raggiunto.

Prendere coscienza

Non esistono ancora, in circolazione, intelligenze artificiali in grado di superare il test di Turing, ossia di imitare il comportamento umano in modo talmente sofisticato da farsi passare per esseri umani; ma questo non vuol dire che le macchine non possiedano consapevolezza. Per esempio il neuroscienziato Christof Koch ritiene possibile che il Web abbia già acquisito consapevolezza di sé, anche se non ce ne siamo ancora accorti. Un’idea sorretta dalla Teoria dell’Informazione Integrata di Giulio Tononi, secondo cui la coscienza emergerebbe dall’integrazione dell’informazione posseduta da ciascuna parte di un sistema complesso (per esempio i neuroni del cervello), ma può sussistere a diversi gradi, il che vuol dire che anche reti neurali artificiali potrebbero possedere un livello primitivo ma quantificabile di coscienza (espresso da un valore che Tononi chiama Φ).

Thomas Ray, lo sviluppatore di “Tierra”, ritiene dal canto suo che il test di Turing sia del tutto inadeguato per rilevare l’eventuale presenza di intelligenza negli organismi che vivono all’interno dei programmi di ALife: “Ritengo che una forma di vera intelligenza artificiale dovrebbe risultare fondamentalmente diversa dall’intelligenza umana (o in generale organica) più di quanto non lo sarebbe un’entità intelligente proveniente da un altro pianeta, perché anche quest’ultima trarrebbe probabilmente origine dalla chimica del carbonio, al contrario di un’entità dotata di intelligenza artificiale”, sostiene.

“Si immagini un’intelligenza artificiale che viva nell’ambiente di Internet… Tale creatura vivrebbe in un universo di informazioni digitali e non nel nostro mondo materiale. I suoi piaceri e le sue sofferenze sarebbero per noi qualcosa di completamente estraneo. Non la scambieremmo mai per qualcosa di umano. Dobbiamo perciò dimenticare il test di Turing!”. Per Ray, dunque, queste forme di vita artificiali devono essere immaginate come radicalmente diverse da quelle che esistono nel mondo intorno a noi: non sono vita come dovrebbe essere, ma vita come potrebbe essere. Come tali, potrebbero anche affrancarsi dalle naturali regole dell’evoluzione, nello stesso modo in cui sarebbero in grado di affrancarsi dai determinanti biologici di base – acqua e carbonio – e dagli standard con cui definiamo la consapevolezza di sé. Sarebbero, in ultima analisi, più alieni degli alieni. Forse, dopo aver speso tanti anni infruttuosi nella ricerca di vita extraterrestre intelligente nell’universo, potrebbe rivelarsi più facile cercare forme di vita intelligente all’interno del nostro sempre più vasto universo digitale.