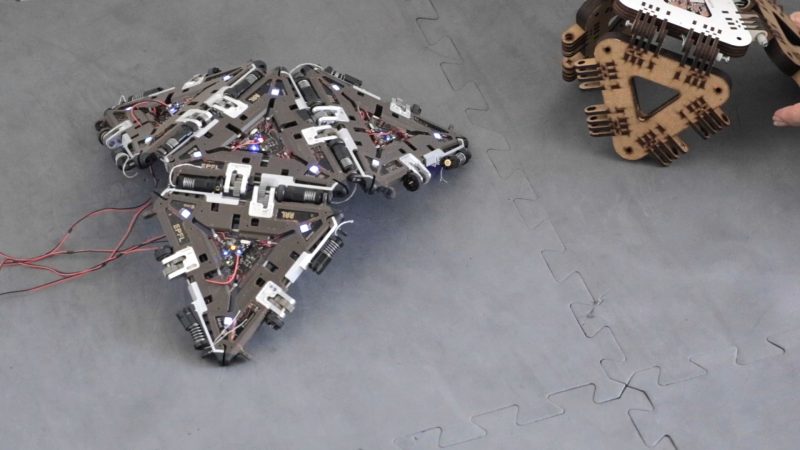

L a prima cosa che vedo è una superficie piatta, dello spessore di un dito, appoggiata su un tavolo. È composta da triangoli equilateri incastrati insieme. Anastasia e Kevin avviano un programma su un computer: la superficie inizia a muoversi, lentamente, come un animale che si sta svegliando. Si accartoccia, e in qualche modo inizia a strisciare sul tavolo. Dalle finestre entra un sole estivo. Sono in una piccola stanza, nell’edificio di ingegneria meccanica della EPFL, la Scuola Politecnica Federale di Losanna.

“Questo si chiama Mori”, mi dice Kevin. “Sta per Modular Origami Robot. I robot origami possono essere piegati in vari modi, a seconda della forma e della funzione desiderata. Come per gli origami di carta, il limite è dato dalla dimensione del foglio che si usa. Però Mori è modulare, quindi si possono aggiungere triangoli a piacimento. Il nostro obiettivo è lo spazio: un robot del genere può essere facilmente trasportato su una stazione spaziale”.

I moduli triangolari di Mori (70 mm per 26 g) hanno attuatori, sensori e controller integrati. “Con una superficie di triangoli, in teoria puoi comporre qualunque oggetto”, mi spiega Anastasia. “Mori può essere smontato e riassemblato per svolgere compiti diversi. Oggi lo manovriamo in modo centralizzato, attraverso un computer che decide come muovere la struttura complessiva. C’è però anche un approccio decentralizzato, in cui ogni modulo decide autonomamente come muoversi affinché l’intera struttura svolga determinati compiti. È una forma di swarm intelligence, come nelle colonie di formiche”.

Anastasia Bolotnikova e Kevin Holdcroft sono ricercatori presso il Reconfigurable Robotics Lab (RRL), uno dei laboratori di robotica della EPFL di Losanna. Oltre a Mori, il prototipo più celebre prodotto da RRL è Tribot, un minuscolo robot autonomo di 10 grammi ispirato alla locomozione della formica trappola (Odontomachus). Tribot è alimentato a batteria ed è costruito con componenti molto semplici, ma è capace di saltare in verticale e in orizzontale, eseguire un salto mortale per superare gli ostacoli, camminare e strisciare. E, proprio come una formica, può operare anche in gruppo.

Fuoco

È fine luglio, fa molto caldo. Passo il pomeriggio a fare foto nel campus quasi vuoto. Due studenti mi vedono, sotto il sole, con il treppiede. “In questo periodo sono tutti in vacanza”, dicono, come per scusarsi. La EPFL è situata a circa 6 km dal centro di Losanna, vicino al lago Lemano. Entro nella biblioteca, il Rolex Learning Center, un edificio a forma di onda progettato dallo studio di architettura giapponese SANAA. È lì che ho appuntamento con L., una studentessa del master in robotica. L. è nata e cresciuta in una grande città del Nordafrica. Mi racconta che ha iniziato il master perché le affascina questo campo scientifico misto, all’incrocio fra ingegneria meccanica, neuroscienze computazionali, biomeccanica, scienze del comportamento e intelligenza artificiale. Mi propone di camminare fino al lago. Anche se sono quasi le sette, il sole è ancora alto sopra le montagne. In spiaggia c’è molta gente, quasi tutti parlano in inglese. L. mi spiega che sono studenti, ricercatori o professori alla EPFL. “Qui andiamo tutti al lago dopo le sei, quando inizia a fare un po’ di vento”. Mi addormento sotto il sole. Sogno una marionetta che si dimena nel fuoco, il suo piccolo corpo di legno annerito dalle fiamme.

A better version of us

Con delle bretelle, Mete si lega al centro del petto una struttura retrattile. La controlla con un joystick, allungandola e girandola a destra e sinistra. “È un robot indossabile”, dice. “Stiamo studiando come cambia la percezione del proprio corpo quando si ha un’estremità in più”. Mete mi chiede se ho una moneta. La appoggia sulla punta del robot e, come mostrando un gioco di prestigio, se la passa nella mano. “Immagina di avere un terzo braccio con una sua autonomia. Come ti sentiresti? Per esempio, sarebbe utile per giocare a baseball, oppure per suonare il pianoforte. Pensa: potrebbe eseguire la parte del basso, lasciandoti le mani libere di occuparsi della melodia”.

Anche Mete Mustafa è un ricercatore al RRL. Lavora sull’integrazione fra macchine ed esseri umani. Mi racconta che ha iniziato a studiare robotica per aiutare le persone. Fin da piccolo sognava di far tornare a camminare una sua parente con disabilità. Nella sua definizione, infatti, un robot è qualcosa che aiuta l’utente – un essere umano, un animale, o una società in generale – ad aumentare le proprie capacità. “Non stiamo cercando di copiare noi stessi; sappiamo che i robot possono svolgere alcuni compiti molto, molto meglio di noi. Quello che cerchiamo di fare attraverso questi strumenti è ottenere una versione migliore di noi [a better version of us]”.

Chiedo a Mete se prevede che nel futuro ci sarà una sfocatura del confine fra esseri umani e macchine, come ipotizzato da Isaac Asimov nel racconto L’uomo bicentenario. “Sì, ma abbiamo bisogno di interfacce più veloci. Quando tocco una superficie con questo braccio robotico, non sento nulla. Cosa accadrebbe se il robot mandasse un segnale di ritorno e, attraverso un decoder, riuscissimo a trasmetterlo direttamente al cervello? Sembra fantascienza, ma se avessimo una parte robotica del corpo che ci mandasse stimoli sensoriali e che fosse controllabile dal cervello, potremmo davvero dire di essere super-umani [super human]. Però dobbiamo studiare gli aspetti psicologici di quello che stiamo facendo”.

Preghiera

“Non deve per forza essere un braccio. In teoria potrebbe avere la forma di una coda, di una proboscide, o delle zampe di un millepiedi”, spiega Jamie Paik, direttrice del Reconfigurable Robotics Lab. “Oppure potrebbe essere una lunghissima lingua. Sono tutte immagini proiettive a cui il cervello può abituarsi o meno”. Jamie mi parla delle ricerche che il RRL sta svolgendo sui robot indossabili, come quello che mi ha mostrato Mete, e su come è possibile manovrarli sfruttando determinate aree del cervello, come quella che controlla il movimento dell’orecchio. “È come utilizzare un joystick, ma invece di azionarlo con le dita, lo guidi dicendo al tuo orecchio di muoversi avanti o indietro”.

Jamie Paik è arrivata a Losanna dopo un diploma in ingegneria meccanica a Vancouver, un dottorato a Seoul, incarichi di ricerca a Tokyo, Parigi e Harvard. “Da piccola volevo essere un’artista”, racconta. “Ho praticato la fotografia, la pittura a olio, la calligrafia, ma mi interessava soprattutto la scultura. Se guardo indietro a quel periodo, credo che oggi il desiderio di creare sia lo stesso; solo il medium è cambiato. Continuo a creare forme, sperimentando con materiali e tecnologie”.

Li vediamo muoversi, e assumiamo che tutto vada bene – mi racconta Jamie Paik – ma c’è comunque un elemento di magia, perché anche se abbiamo programmato tutto perfettamente, sappiamo che per qualche motivo potrebbe non funzionare. È sempre un atto di fede.

Jamie ha fondato RRL nel 2012, con l’obiettivo di creare robot agili, flessibili e adattabili a diversi contesti. Secondo lei un robot deve avere quattro elementi: cervello, corpo, percezione e autonomia. “Dipingere automobili, muovere oggetti da A a B: queste erano le cose che i robot erano progettati per fare. Invece qui sviluppiamo robot che si riconfigurano, si adattano e si trasformano secondo i profili e le necessità di chi li usa. Attualmente, qualsiasi tipo di prodotto commerciale è rivolto a una particolare fascia demografica, emarginando tutti gli altri. La mia utopia a breve termine è che queste tecnologie siano disponibili per tutti, non solo per chi rientra nel target di clientela. Ognuno ha una predisposizione biomeccanica, una geometria, una libertà di movimento diversa, perciò abbiamo bisogno di robot riconfigurabili. Stiamo creando fantascienza: realizziamo quello che il futuro sarà”.

Racconto a Jamie del mio interesse per l’animazione di oggetti antropomorfi, come marionette e burattini. Le chiedo se vede un parallelo fra robotica e teatro di figura. “Si tratta di realizzare estensioni di noi stessi attraverso un altro mezzo”, risponde. “È una pratica che è sempre esistita: prima si usava l’argilla o la roccia. I marionettisti attaccano dei fili agli arti di un pupazzo e poi li manovrano con le dita. In robotica, al posto dei fili ci sono dei cavi elettrici; invece delle mani usiamo la corteccia cerebrale. L’input è lo stesso, è diverso il modo in cui viene eseguito”.

Non riesco a trattenermi: chiedo a Jamie della “singolarità”, cioè di quell’ipotetico momento futuro in cui il progresso tecnologico avrà accelerato oltre la capacità degli esseri umani di controllarlo. Se i robot avranno sempre più autonomia, cosa avverrà quando non riusciremo più a capirli? Lei mi interrompe: “Già ora non li capiamo. Quando non funzionano, molto spesso non sappiamo il perché. E, quando funzionano, invece di accontentarci ci chiediamo perché il giorno prima non funzionavano”. Si fa più seria, e continua: “Li vediamo muoversi, e assumiamo che tutto vada bene: il sensore, il controller, il comando, l’alimentatore… Ma c’è comunque un elemento di magia, perché anche se abbiamo programmato tutto perfettamente, sappiamo che per qualche motivo potrebbe non funzionare. È sempre un atto di fede. Ti faccio un esempio: quando usi la tua chiave per aprire la porta di casa, già sai che si aprirà. Non ci sono sorprese. Ma immagina di essere un ladro che deve scassinare una serratura: se la porta si apre, c’è un momento di euforia. Ecco, ogni volta che accendiamo un robot, gli diamo vita e fa quello che ci aspettavamo, è un momento magico, di gioia, euforia. È come se dicessimo sempre una piccola preghiera: fa’ che funzioni questa volta, fa’ che funzioni questa volta…”

Bivi

L. mi invita a mangiare un panino in un’aula studio quasi deserta. Mi parla della sua infanzia. Ha praticato danza classica fino ai 12 anni, allenandosi tutti i giorni, finché si è rotta la caviglia. È da quel momento che si è appassionata alle macchine che si muovono da sole. Dice che voleva costruire una ballerina meccanica capace di eseguire una gargouillade, un complicato passo di danza.

Poi mi presta un libro, che mi consiglia di leggere. È la traduzione in inglese di Robot, di Adam Wiśniewski-Snerg – un autore polacco che in vita non conobbe troppo successo, morto suicida nel 1995. In una struttura narrativa che ricorda sia Kafka che L’invenzione di Morel, il narratore si aggira per le sale di un ambiente sotterraneo, dove una comunità si è rifugiata in seguito a un evento apocalittico. Nel frattempo, cerca di scoprire se lui stesso è un robot o un essere umano.

Ringrazio L. e le espongo una curiosità. Quale sarebbe la forma letteraria giusta per raccontare il punto di vista di un robot? “Sicuramente il libro-game”, risponde subito, ridendo. “Quando scriviamo un algoritmo è come se dicessimo alla macchina: «Sei qui, in questa situazione. Se succede α, allora vai a pagina X e fai questo; se invece succede β, allora vai a pagina Y e fai quest’altro». È proprio come una storia a bivi. Poi, per robot più complessi l’algoritmo diventa qualcosa come: Guardati intorno. Analizza la situazione. Cosa scegli di fare, fra le opzioni che hai a disposizione?”

Embodiment

Pomeriggio. Una stanza sotterranea. C’è una piccola piscina, dove sta nuotando un serpente nero e giallo. Al mio fianco c’è Alessandro, che tiene in mano un telecomando. “Si chiama AmphiBot”, mi dice. “È un robot anfibio, ispirato alla lampreda”. Mi mostra l’immagine di un pesce dal corpo lungo e cilindrico, simile a un’anguilla ma con una bocca circolare ricoperta da denti cornei. Il robot ha dei LED lungo il dorso. Alessandro spegne la luce, e restiamo per un po’ a guardare una fila di punti luminosi che ondeggia nel buio. Poi mi passa il telecomando, e subito il serpente inizia a nuotare in modo sgraziato.

Alessandro Crespi lavora al BioRob, un altro laboratorio di robotica di stanza alla EPFL, che studia gli aspetti computazionali della locomozione, della coordinazione sensomotoria e dell’apprendimento. Il BioRob usa i robot per analizzare i meccanismi neurali alla base del controllo del movimento negli animali, e, viceversa, si ispira agli animali per progettare robot capaci muoversi in ambienti complessi.

A capo del laboratorio c’è Auke Ijspeert, che incontro qualche giorno dopo nel suo ufficio. Mi racconta che fin da piccolo era incuriosito dagli animali, e in particolare dal loro movimento. Invece di studiare biologia ha però scelto fisica, per capire come funzionano i neuroni. Un giorno, sulla rivista Scientific American ha letto un articolo sulla lampreda. Ne è rimasto affascinato, tanto da dedicare gli anni seguenti a creare modelli della sua locomozione, simulando i muscoli, i neuroni e l’acqua, usando algoritmi genetici e circuiti oscillatori neurali artificiali. Questa ricerca lo ha portato a ottenere un dottorato in intelligenza artificiale all’Università di Edimburgo. “È così che sono arrivato alla robotica”, dice. “Lavoravo ai miei modelli al computer, ma sognavo di realizzarli concretamente, costruendo un robot che incarnasse la simulazione”.

Auke Ijspeert mi spiega che il suo BioRob ha tre missioni principali: comprendere, progettare, assistere.

Auke mi spiega che il BioRob ha tre missioni principali. La prima è comprendere la locomozione degli animali, usando i robot per testare ipotesi in biologia, neuroscienze o paleontologia. La seconda è progettare forme di locomozione, realizzando robot che possono muoversi all’aperto, in acqua o in luoghi difficili da percorrere. La terza è assistere la locomozione di persone con mobilità limitata, tramite tecnologie domestiche assistive, esoscheletri motorizzati e robot indossabili.

Il prototipo più celebre costruito dal laboratorio è OroBot, ispirato a un orobate vissuto 300 milioni di anni fa – un vertebrato erbivoro a metà fra anfibio e rettile. Basandosi su un fossile e su delle impronte, il BioRob (insieme a un team interdisciplinare della Humboldt-Universität di Berlino) ha costruito un robot in grado di replicare la morfologia e la locomozione dell’animale estinto. Nel 2019 OroBot è finito sulla copertina di Nature, col titolo “Robot Palaeontology”.

Ho letto in un articolo che molti ricercatori stanno cercando di fondere intelligenza artificiale e robotica per creare sistemi in grado di prendere decisioni autonomamente e controllare un corpo fisico nel disordinato e imprevedibile mondo reale. Chiedo ad Auke se nel suo lavoro le due discipline si accavallano, come corpo e mente in un animale. “Penso che la robotica abbia ovviamente bisogno dell’intelligenza artificiale”, risponde, “mentre non è vero il contrario. Negli animali, però, l’intelligenza è sempre incarnata [embodied], legata a un corpo, e non credo che raggiungeremo mai una intelligenza artificiale generale [AGI] senza questa incarnazione. Molto di quello che siamo passa attraverso la percezione attiva, il tatto, l’interazione con la fisica del mondo. Ruminando solamente dati, come fa un’IA, restiamo troppo distanti. In robotica, invece, hai l’incarnazione”. Fa una pausa, e poi riprende, come per spiegare meglio. “Alcune delle attività che reputiamo legate all’intelligenza provengono dalla pura meccanica. Gran parte della locomozione animale, ad esempio, è già intrinseca ai muscoli, alla morfologia corporea. E questo vale anche per i robot, in cui la meccanica è fondamentale. La robotica abbina l’intelligenza artificiale al corpo, all’embodiment”.

Auke mi fa visitare il BioRob. Osservo scaffali con zampe, code, scheletri e prototipi di animali di varie forme. Mi fa pensare al deposito di un museo di storia naturale. È periodo di vacanze estive, sono pochi i ricercatori al lavoro. Una di loro ha portato suo figlio, un bambino di due anni. Per farlo divertire, attivano un cane meccanico. Appena inizia a muoversi, il bambino scoppia a piangere.

Prima di salutarlo, chiedo ad Auke se ha letto i libri di Asimov, se conosce le “tre leggi della robotica”. Appena mi sente parlare di fantascienza, sorride. “Oggi iniziamo ad avere classificatori e una buona machine vision”, dice, “ma la maggior parte dei nostri modelli non saprebbe ancora riconoscere un essere umano. Credo che stiamo esagerando con tutti questi discorsi sui robot che diventano autocoscienti, conquistano il mondo e tutto il resto. Lavorare con la robotica ti rende umile. Sì, chiaramente si fanno progressi; a volte si arriva a pensare che raggiungere gli animali forse non è un obiettivo così distante. Ma poi c’è sempre qualcosa che manca, e l’orizzonte si allontana. Ad esempio, gli animali possono auto-ripararsi. Se perdono un arto, possono riadattarsi. Sono agili, flessibili e hanno una locomozione perfettamente adatta all’ambiente in cui vivono. Per non parlare di coscienza e cognizione, che non sappiamo ancora cosa siano davvero. Più facciamo ricerca, più ci rendiamo conto di quanto questa ‘singolarità’ sia ancora molto, molto lontana”.

Gradiente

Qualche giorno dopo, di nuovo al Reconfigurable Robotics Lab. Fabio Zuliani, un ricercatore, mi mostra una serie di superfici robotiche che sta sviluppando. Sono interfacce aptiche, cioè capaci di fornire all’utente sensazioni tattili. Schermi per il tatto, invece che per la vista. “Quando stiamo al computer e ci serviamo di tastiera e mouse”, mi spiega, “la maggior parte delle informazioni che riceviamo sono visive. Il mio progetto di dottorato è realizzare una superficie robotica, che renda qualsiasi supporto – pareti, pavimenti, porte – interattivo. La superficie comunica con la pelle umana cambiando forma e rigidità. È un modo integrato di usare la tecnologia”.

Ho notato, dico a Fabio, che per alcuni prototipi di robot – come Mori o AmphiBot – l’obiettivo è l’indipendenza dal controllo umano (“It has to be mobile and largely independent”, scrive Paik in un paper). Altri modelli, invece – come il terzo braccio su cui lavora Mete – tendono all’integrazione, fin quasi a sfumare la distinzione fra macchina e utente. Fabio mi interrompe: “Autonomia e integrazione sono due facce della stessa medaglia. La robotica opera in un gradiente tra questi due parametri. Ad esempio, i cani Spot della Boston Dynamics sono completamente autonomi, ma devono comunque essere integrati nell’ambiente umano – non fisicamente, ma socialmente. Ieri guardavo il video di un cane robot su cui era stata montata una mitragliatrice: questo è il genere di cose che aumenterà il divario tra ciò che la tecnologia può fare e ciò che è accettato dal pubblico. All’altro lato del gradiente ci sono i robot indossabili: è vero che sono progettati per funzionare su un essere umano ma, anche per ragioni di sicurezza, devono possedere una loro autonomia”.

Secondo Fabio, in futuro i problemi saranno soprattutto di natura sociale. “La cosa più complicata è capire cosa faremo con chi perderà il lavoro”, mi dice. “Dobbiamo trovare lavori nuovi, giusto? Non è così facile. Non puoi prendere tutti i cassieri e semplicemente trasformarli negli ingegneri che si occupano delle macchine che li sostituiranno. È vero: nel lungo termine penso che non tutti dovranno lavorare per sopravvivere, ma questa sarà una questione sociale completamente nuova, molto complessa. Finiremo per avere una società in cui alcune persone non faranno altro che leggere libri e guardare film? E come vivranno insieme alla parte della popolazione che invece dovrà lavorare? Ci saranno due categorie separate? Ciò che temo di più è che la tecnologia andrà più veloce della politica, ed è uno dei motivi per cui penso che gli scienziati dovrebbero essere molto più coinvolti politicamente”.

Aura

Ultimi giorni a Losanna. Incontro L. per restituirle il libro di Wiśniewski-Snerg. Le leggo un passaggio che ho ricopiato:

Gli uomini si erano sempre illusi che ciò che li rendeva umani fossero i loro pollici, la loro postura eretta, e soprattutto il loro cervello. Ma alcuni si chiesero cosa sarebbe accaduto in futuro quando un manichino, eretto e dotato di un corpo sintetico e di arti mobili, avrebbe rivolto la testa, farcita con un cervello elettronico, verso il suo costruttore, e avrebbe affermato con convinzione: “Sono un essere umano!”

L. mi porta a vedere gli EPFL Pavilions, spazi espositivi interdisciplinari dedicati a progetti fra arte e scienza (come la mostra Nature of Robotics, curata nel 2020 da Giulia Bini). Uscendo, le chiedo cos’altro mi suggerisce di visitare. Secondo L., i laboratori di robotica all’EPFL esemplificano abbastanza bene le varie linee di ricerca odierne. Ci sono i robot origami, quelli indossabili e quelli modulari (RRL). Ci sono i robot ispirati agli animali, e quelli che assistono la mobilità (BioRob). E poi ci sono altri laboratori, come il MICROBS (MicroBioRobotic Systems), che sviluppa micro-dispositivi in nanocompositi di idrogel, ispirati ai batteri e capaci di nuotare nei vasi sanguigni; o il LIS (Laboratory of Intelligent Systems), che prende spunto dagli uccelli per progettare droni che volano in sciami.

L., però, mi consiglia di visitare il LASA. Il Learning Algorithms and Systems Laboratory è diretto da Aude Billard, esperta di interazioni fra esseri umani e macchine. Anche qui si lavora ad interfacce neurali, per interpretare segnali dal cervello e poi tradurli nell’articolazione di un braccio robotico. Inoltre, il laboratorio coniuga control theory e machine learning per insegnare ai robot ad eseguire specifiche attività. Con l’obiettivo di sviluppare tecniche di insegnamento per i robot, Billard ha studiato i processi neurali e cognitivi alla base dell’apprendimento per imitazione negli esseri umani.

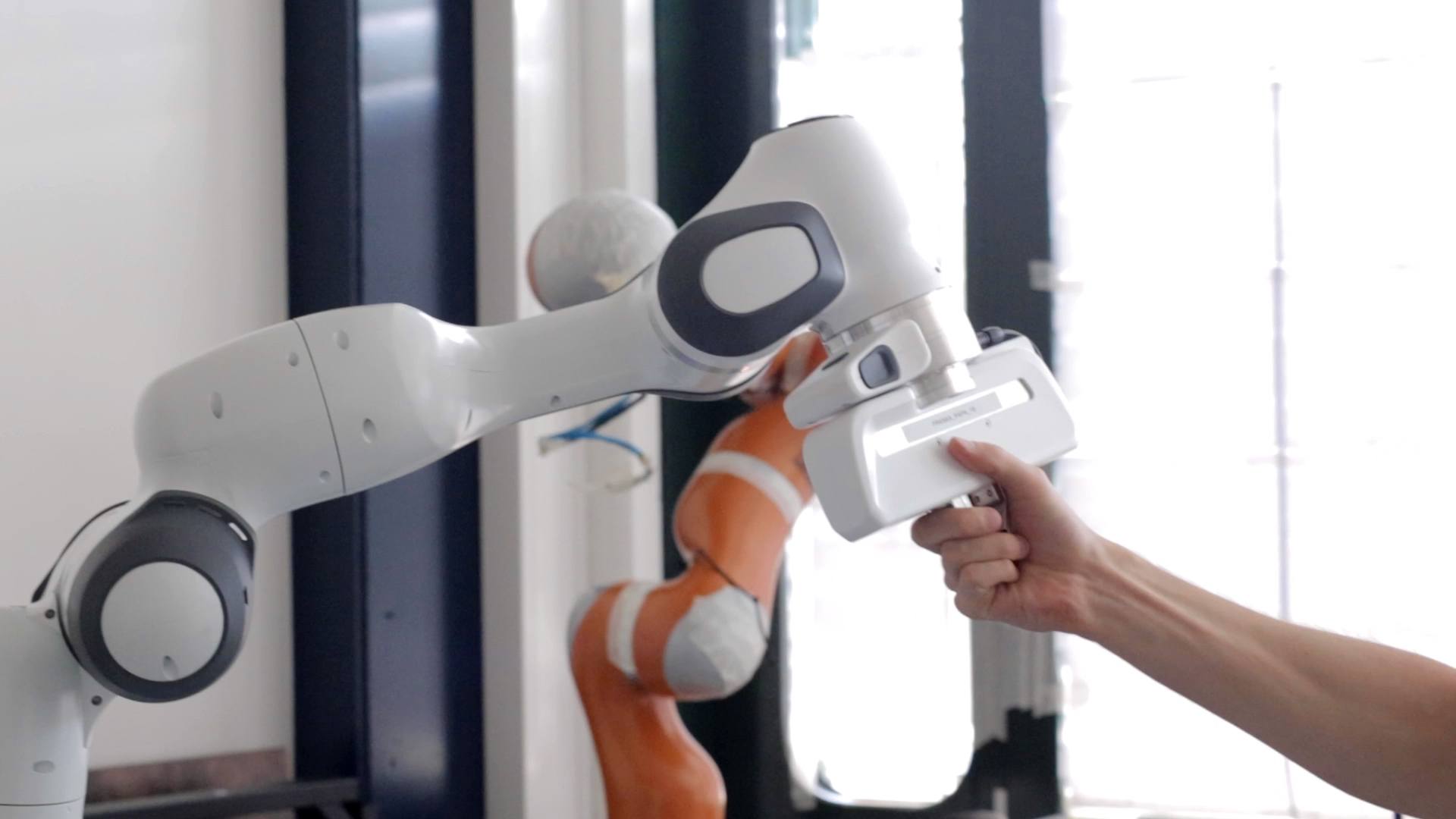

Un video sul sito del LASA mostra un esempio di ‘dimostrazione cinestetica’. Una ricercatrice è in piedi davanti a un tavolo, fra due grandi bracci meccanici arancioni: uno sostiene una zucchina, l’altro un pelapatate. Come una marionettista, la ricercatrice muove i due bracci in modo che sbuccino la zucchina. I movimenti sono poi registrati da un computer, per estrarre un modello probabilistico che codifica la sequenza di azioni, la rigidità e la forza applicata. Questo sistema consente a un robot di apprendere un gesto e di riprodurlo correttamente.

A mostrarmi il laboratorio sono David Gonon e Lukas Huber, due ricercatori. Stanno insegnando a un braccio meccanico ad avvicinarsi a un piccolo oggetto, simile a una pallina da ping-pong. Con le mani lo spingono da una parte e dall’altra, e il robot torna lentamente ma caparbiamente in posizione. Lo toccano con cura, come due fantini che accarezzano la testa di un cavallo. A lato, su uno schermo, ogni sua mossa viene tracciata su uno spazio virtuale, in una ragnatela di linee bianche.

“Anche noi umani operiamo in modo simile”, dice Lukas. “L’insegnante ti prende la mano, ti mostra come fare, e tu lo rifai. E poi sono prove ed errori, ripetutamente, finché non capisci come farlo bene. L’intelligenza artificiale lavora in modo simile. Da un punto di vista robotico, però, la correzione e l’adattamento funzionano solo in alcuni casi. La parte attiva della ricerca consiste nel rendere questi insegnamenti applicabili e utili in maniera più generale”.

Finito il giro, David e Lukas mi offrono un caffè. Ci sediamo in terrazzo. Si vedono il lago e le montagne, sullo sfondo del campus. Chiedo a loro di darmi una definizione generale: che cos’è, in essenza, un robot? “Qualcosa che può agire come segnaposto per un essere umano [a placeholder for a human],” risponde David, “con caratteristiche che lo fanno assomigliare a un essere umano, a un animale, o ad ogni modo a qualcosa di vivente”. Osservo che allora anche una marionetta rientrerebbe in questa definizione, che non include alcuna forma di autonomia. “Sì, ma l’autonomia rientra fra le caratteristiche che ci somigliano”, ribatte lui, “per questo la attribuiamo ai robot”.

“No,” interviene Lukas, “per me non deve assomigliare per forza a una forma vivente. Secondo me, la caratteristica essenziale è l’adattabilità. Deve essere capace di fare una varietà di cose, sia eseguendo comandi forniti dall’essere umano, sia adattandosi ed evolvendo automaticamente”.

Possiamo pensare alla robotica come una ricerca su di noi: forse è per questo che studiamo come funzionano le macchine, i corpi, le forme di vita – alla fin fine, forse stiamo studiando come funzioniamo noi stessi.

Cerco di formulare una serie di impressioni che mi hanno lasciato gli incontri di questi giorni. Nella fantascienza, i robot sono spesso raffigurati come entità umanoidi che si allontanano da noi, che diventano autonome e prendono il controllo. Mi ritrovo a menzionare di nuovo la “singolarità”. Eppure, aggiungo, possiamo pensare alla robotica come una ricerca su di noi: forse è per questo che studiamo come funzionano le macchine, i corpi, le forme di vita – alla fin fine, forse stiamo studiando come funzioniamo noi stessi.

Mi fermo. David e Lukas mi guardano, dubbiosi. Poi, sorridendo, Lukas inizia a parlare. “Sì, in un certo senso ho imparato molto su come noi, in quanto umani, facciamo le cose. Anche i movimenti più semplici, se voglio farli eseguire a un robot, non sono più così semplici. Spesso mi ritrovo nel mio ufficio a chiedermi: ‘Come riesco a prendere in mano questa tazza? Qual è il processo mentale per arrivare a farlo?’ E più provo a trasformarlo in righe di codice, più diventa una sfida anche vedere il movimento stesso”. Fa una pausa. “Sai, stiamo studiando come può comportarsi un robot in mezzo a una folla. Per scrivere un algoritmo, bisogna guardare come si comportano le persone che compongono la folla. E, in questa folla, come dovrebbe integrarsi il robot per essere il più naturale, il più umano possibile?”

Dopo un breve silenzio, interviene David: “C’è una specie di effetto spettacolo che agisce su di noi e sulle persone che poi vedranno i risultati del nostro lavoro. Mentre sviluppo un robot, ricevo l’aura di questa cosa che ho di fronte. Mi ispira a continuare: guardo come si muove, come appare, sento che impressione mi dà. La macchina diventa un oggetto sociale. Dobbiamo guardarla, dobbiamo studiare come la guardano gli altri. La percepiamo in molti modi: non solo a livello matematico o tecnologico, ma con tutti i sensi. Per questo dico che ha un’aura: a volte avviene una sorta di magia”.

Il testo si basa su conversazioni svolte a luglio 2022 presso la EPFL, durante il CDH Artist in Residence Program ‘Enter the Hyper-Scientific’ curato da Giulia Bini.