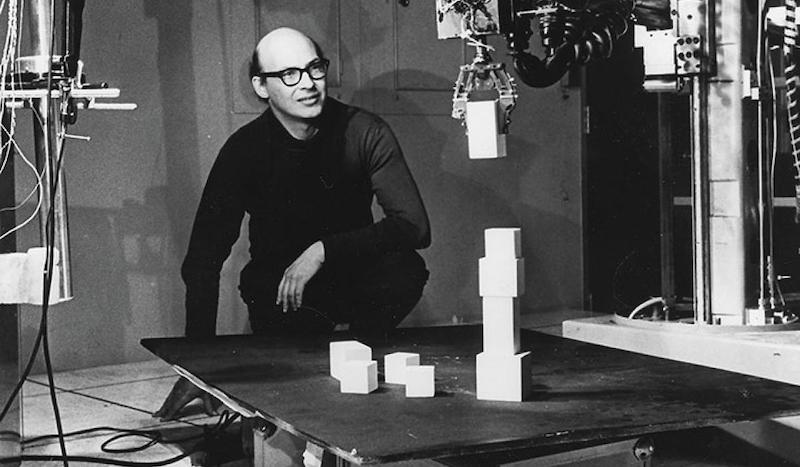

N el suo ultimo libro, L’occhio della macchina (Einaudi editore), Simone Arcagni racconta di uno dei primi esperimenti di laboratorio per dotare i computer di una visione artificiale. È il 1966 e siamo al laboratorio di Intelligenza Artificiale dell’MIT di Boston, fondato dal matematico Marvin Minsky. “Minsky propone allo studente Gerald Jay Sussman di passare l’estate provando a connettere una camera a un computer e chiedere alla macchina di descrivere cosa ‘vede’”.

È un esperimento ingenuo per i canoni di oggi; immaginato quasi come se fosse sufficiente collegare una telecamera a un computer per creare un sistema in grado di vedere. “Minsky sa che il processo di apprendimento che prefigura la costruzione di una qualche forma di intelligenza, a partire dall’immagazzinamento di dati e informazioni, fino alla loro trasformazione ed elaborazione, avviene fondamentalmente attraverso la vista. L’intuizione è quella di dotare il computer di questa facoltà”.

Da un certo punto di vista, questo esperimento ricorda i tentativi, falliti anche quelli, di creare una vera intelligenza artificiale dotandola di tutte le conoscenze dell’uomo: un meccanismo “dall’alto” secondo il quale, per esempio, sarebbe stato sufficiente dare in pasto a un software i dizionari e i libri di grammatica di italiano e francese perché imparassero a tradurre da una lingua all’altra. È un sistema che, nei casi in cui si seguono regole molto precise (come negli scacchi), ha portato a qualche successo, ma che certamente non poteva funzionare in settori pieni di sfaccettature come il linguaggio.

Se ne accorse anche Marvin Minsky, vedendo fallire il suo esperimento: “È quello il momento in cui si è capito che non si poteva replicare l’occhio umano collegando una telecamera a un cervello informatico”, racconta a Il Tascabile Simone Arcagni. “L’idea era probabilmente venuta a Minsky dalla lettura del saggio di Alan Turing Computing Machinery and Intelligence, in cui sostiene che, per dotare la macchina di un vero cervello, sarebbe stato necessario fornirle prima la vista, l’udito, l’olfatto”. Noi capiamo le cose perché abbiamo esperienza del mondo, mentre la macchina non possiede questa esperienza. “Si riteneva quindi che il primo passo da compiere fosse proprio dotarla degli strumenti – i sensi – necessari a conoscere ciò che la circonda”.

Ma da dove nascono le idee che hanno reso, oggi, la computer vision uno degli elementi fondanti dell’intelligenza artificiale, con applicazioni nel campo medico, delle auto autonome, della sorveglianza? Nei dodici capitoli del libro, Simone Arcagni riesce a ricostruire lo sviluppo di una disciplina informatica le cui origini più antiche risalgono al pensiero di Platone, e che trova invece le sue basi scientifiche moderne nel lavoro di filosofi come Leibniz, Pascal e Cartesio. Per poi arrivare agli sviluppi compiuti negli ultimi decenni: come vede una macchina? In cosa differisce la visione artificiale da quella umana e cosa succede quando queste si fondono nella realtà aumentata e virtuale? Arcagni scruta in profondità l’occhio della macchina, intraprendendo un viaggio matematico, cibernetico e algoritmico in uno dei settori più affascinanti dell’innovazione tecnologica.

Un settore che compie un cruciale salto di qualità proprio quando, in seguito al suo fallimentare esperimento, Marvin Minsky comprende che l’approccio da seguire dev’essere differente. A questo scopo invita al MIT David Marr, neuroscienziato e informatico che inizia a studiare non solo il modo in cui noi vediamo, ma soprattutto come interpretiamo ciò che vediamo e come il cervello comprende, per esempio, cosa c’è in primo piano o cosa invece sia un contorno. David Marr inizia a studiare come insegnare alle macchine a comprendere tutto questo. “Le neuroscienze hanno permesso di capire che la funzionalità visiva di un computer non va immaginata come se fosse un occhio che si apre e si chiude o la cui pupilla si dilata. Quello che davvero importa è il sistema che ci permette non solo di vedere, ma anche di riconoscere gli oggetti, di memorizzarli, di interpretarli…”, prosegue Arcagni. “Tutto questo si è potuto fare quando si è cominciato realmente a studiare come vedono le persone e anche perché alcune persone vedono diversamente da altre o hanno delle anomalie visive”.

È proprio con David Marr che si inizia a parlare di computer vision (il suo saggio fondamentale nel 1982, pubblicato postumo, si chiama Vision), anche se lui preferiva il termine neuroscienze informatiche, che trasmette più precisamente l’idea di comprendere tutti i significati che noi raccogliamo sotto il verbo vedere. “L’informatica ha vissuto per qualche momento l’idea e l’utopia di poter trasformare alcune funzioni biologiche umane ricreandole in maniera tecnologica”, racconta Arcagni. “Invece bisognava trovare una via macchinica, che copiasse solo alcune funzioni – come le reti neurali imitano le sinapsi”.

Per l’apprendimento, per esempio, col tempo ci si è affidati al sistema opposto rispetto a quello “dall’alto”: lasciare che le macchine imparassero autonomamente, fornendo loro tutti i dati utili all’apprendimento di un determinato esercizio. Per il riconoscimento dei numeri scritti a mano, così, non si doveva insegnare alla macchina com’è fatto un 5, ma le si dovevano fornire decine di migliaia di numeri correttamente etichettati; dopodiché, sarebbe stato compito dell’algoritmo imparare in autonomia a distinguerli con precisione.

È il metodo che ancora oggi è alla base del machine learning e degli algoritmi di intelligenza artificiale, che – nonostante imitino per certi versi il funzionamento del cervello – creano uno scarto decisivo rispetto all’idea di inserire forzatamente nelle macchine le conoscenze umane. “Lo stesso è avvenuto per l’occhio umano: si pensava di poterlo replicare sia in robotica sia in computer vision; poi ci si è resi conto che si doveva sviluppare un percorso in buona parte indipendente”.

In poche parole, l’occhio della macchina non sarà mai l’equivalente artificiale dell’occhio umano, ma un sistema completamente differente con abilità diverse dalle nostre: “Da un punto di vista quantitativo, per esempio, la visione artificiale è più potente dell’occhio umano; basti pensare all’hyperimaging di IBM che permette di vedere cose che noi non potremmo mai visualizzare da soli e che arrivano anche da spettri non ottici. Questo non significa che la computer vision sia migliore dell’occhio umano – che per esempio ha qualità in termini di adattabilità e connessione con un cervello creativo che potrebbero essere irraggiungibili – ma che ha accesso a una dimensione quantitativa e a dati a cui l’uomo non può accedere”.

Invece che procedere per imitazione, insomma, ci si deve muovere in direzioni completamente diverse. D’altra parte, anche solo parlare di vista può essere fuorviante. Quando si parla di computer vision – la tecnologia che, tra le altre cose, permette alle auto autonome di riconoscere e interpretare ciò che le circonda – si tende a immaginare che i sensori utilizzati dal software possano, letteralmente, vedere. Le cose non stanno così: “La macchina non vede niente, è cieca”, dice Simone Arcagni. “Siamo noi che le diciamo di interpretare in senso visivo alcuni dei dati che riceve. Per esempio, la maggior parte dei dati che riceviamo dalle sonde dello spazio non sono ottici. Quando sentiamo parlare di un apparecchio che ha visto oltre la galassia, in realtà non ha visto proprio niente; ha ricevuto dei dati che noi, dopo averli elaborati, possiamo riproporre come fossero immagini”.

Tutto questo crea un elemento di rottura rispetto al passato, quando tutte le macchine ottiche – dal telescopio di Galileo in avanti – avevano la funzione di amplificare la potenza del nostro occhio. “Oggi invece stiamo creando macchine autonome, dispositivi molto complessi che elaborano dati, ma che non ripropongono e non potenziano le funzionalità dell’occhio. È anche per questo che sostengo che si debba studiare il settore del visivo digitale come se fosse una biologia”. Come se stessimo sviluppando una biologia artificiale con l’obiettivo di creare delle entità biologiche non viventi. “Non sono un transumanista o un seguace della singolarità, non sto dicendo che ci riusciremo; ma la via che stiamo intraprendendo è questa”.

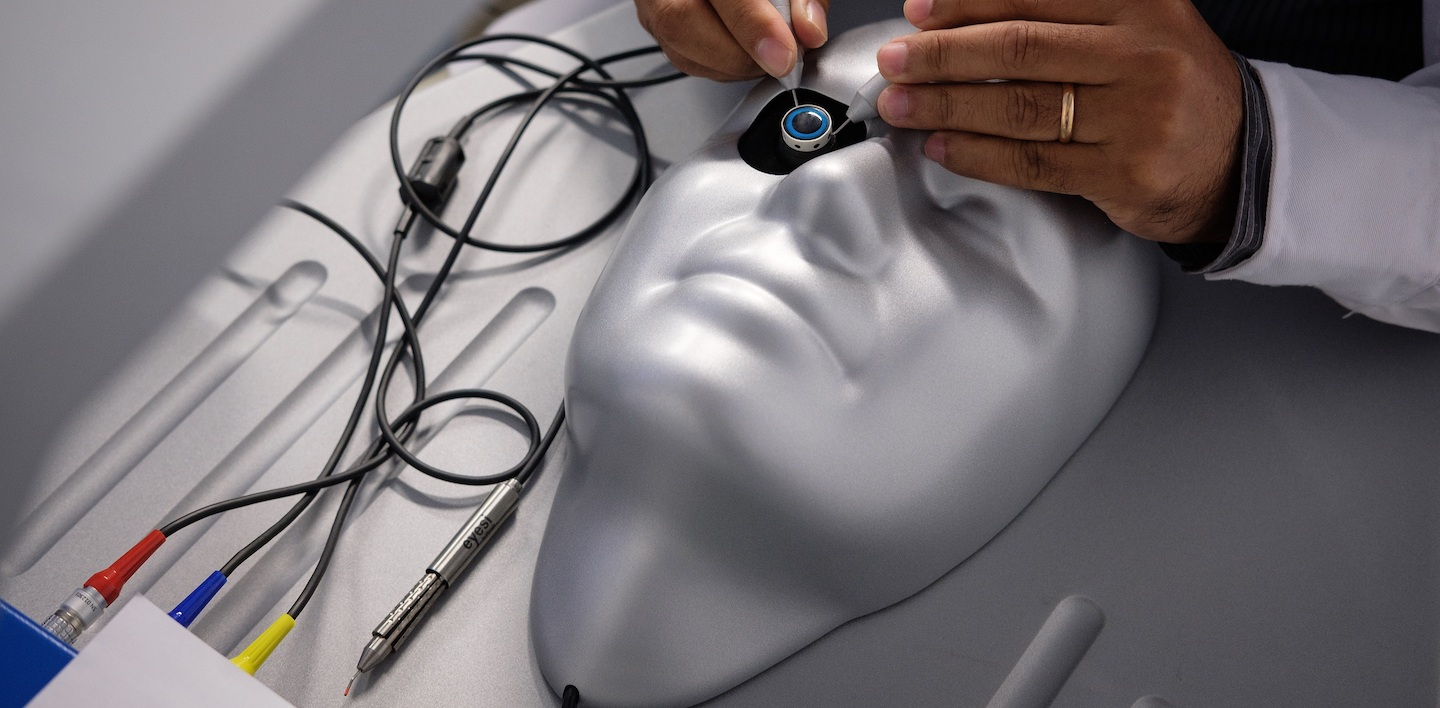

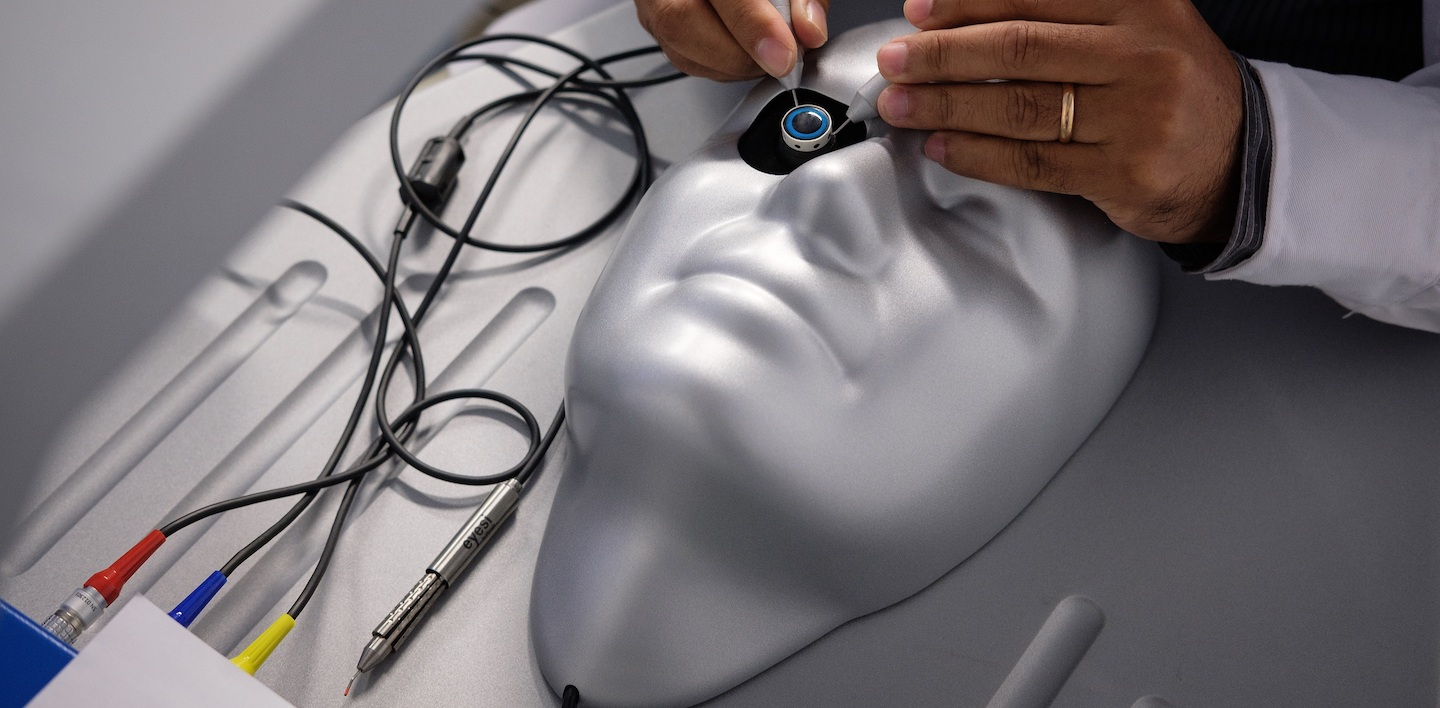

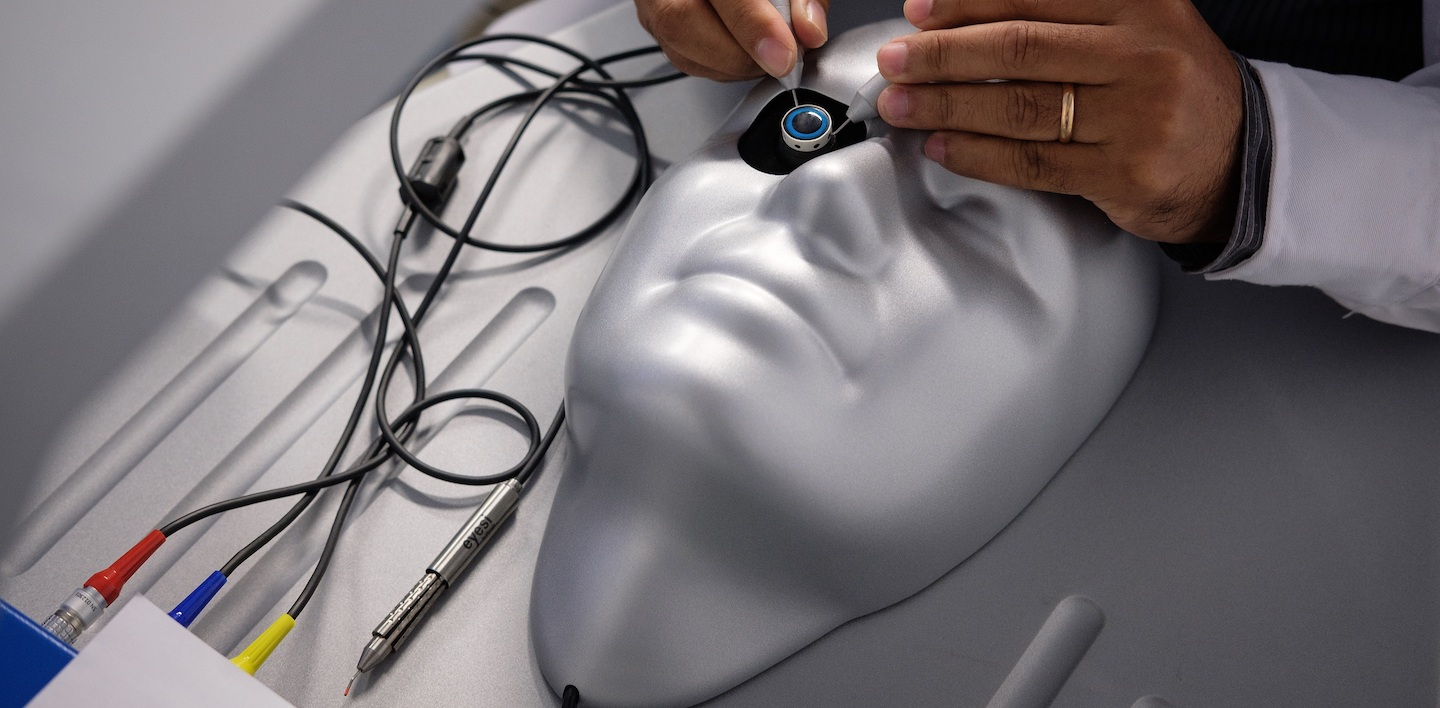

L’ibridazione di queste tecnologie con il cervello umano apre opportunità stupefacenti. “Si parla molto di impianti artificiali collegati ai nervi ottici per riparare malfunzionamenti della vista”, spiega Arcagni. “Un artista come il britannico Neil Harbisson, che in natura non riesce a distinguere i colori, si è fatto impiantare un’antenna nel cervelletto che capta i segnali visivi e gli consente, in un certo senso, di vederli”. L’antenna, infatti, cattura i colori grazie a un sensore e li converte in frequenze audio differenti; comunicandole ad Harbisson e permettendogli di superare un’anomalia congenita, l’acromatopsia, che limitava la sua visione a una scala di grigi.

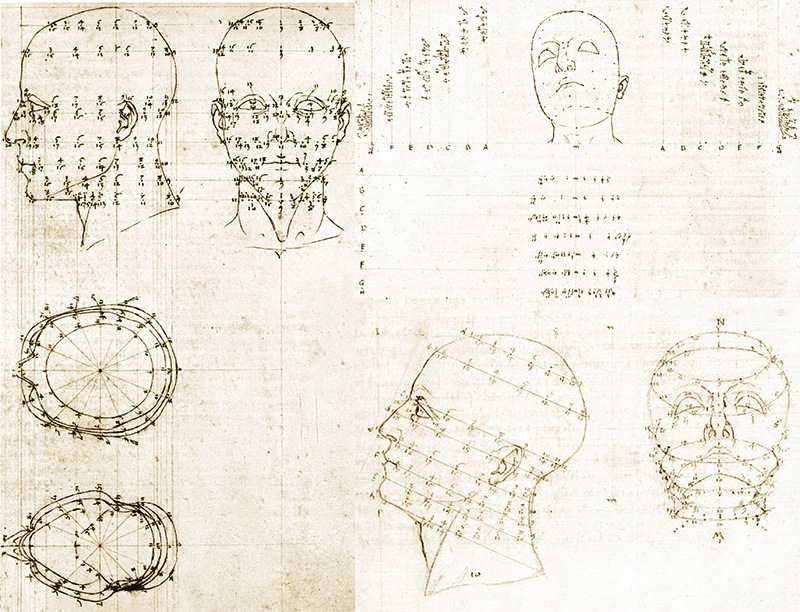

Sistemi futuristici, che potranno avere un grande impatto sulla società, e che affondano le loro origini in epoche antiche, secondo la visione di Arcagni. “Leonardo, Galileo, Cartesio e poi il Barocco a cavallo tra Seicento e Settecento”. È lì che nasce e si sviluppa l’idea della scienza come possibilità di comprendere il mondo e della matematica come linguaggio formale che permette di descrivere queste scoperte. “L’osservazione scientifica può essere metrizzata e riprodotta dal linguaggio matematico. Nel Barocco, poi, si passa dall’abaco alla pascalina di Pascal e alla macchina di Leibniz; sistemi che permettono di fare calcoli evoluti e arrivare in alcuni casi anche alla moltiplicazione. Di fatto, si tratta dei primi elaboratori. Ma questo è anche il secolo in cui ritorna l’interesse nei confronti degli automi e in cui si cercano di riprodurre funzioni umane complesse come, appunto, la vista”.

La volontà di descrivere il mondo in termini matematici è alla base della rivoluzione digitale che stiamo vivendo oggi. È quindi in quei secoli che si gettano i primi semi della futura computer vision? “Nell’età barocca si perfezionano le lanterne magiche e la camera oscura; è il periodo in cui si concepisce un’idea nuova di visivo. Andando a ritroso, ovviamente, tutto questo non nasce all’improvviso, ma con il metodo cartesiano, con Galileo e Leonardo e quindi arrivando fino al Rinascimento; quella è già un’epoca in cui si inizia a vedere la matematica come il linguaggio della costruzione del mondo”.

Sotto questo aspetto, un passo fondamentale è sicuramente la scoperta della prospettiva: “La prospettiva è l’applicazione matematica di concetti visivi; non poteva che nascere in una società che l’aveva eletta a suo linguaggio primario”, spiega Arcagni. E allora l’importanza di Piero della Francesca è cruciale, perché “la sua prospettiva è quella non solo più affascinante, ma ancora oggi la più perfetta dal punto di vista scientifico. Il lavoro matematico e geometrico che ha svolto è qualcosa di incredibile”.

D’altra parte è proprio il Rinascimento l’epoca in cui viene “metrizzata” la visione del mondo. “Cominciano a prendere potere i mercanti, che hanno bisogno di contare i loro denari e quantificare con precisione le merci da caricare sulle navi. Ed è sempre nel Rinascimento che nascono le banche e gli assegni, assieme alle proiezioni geometriche e agli assi cartesiani”. Ovviamente, nulla nasce dal nulla e risalire alle origini della visione scientifica che ha posto le basi della rivoluzione digitale ci porta ad attraversare il Medioevo (“Non è un caso che il protagonista de Il nome della rosa, che cito in apertura del mio libro, porti gli occhiali: è il simbolo della sua volontà e necessità di capire”) e approdare, inevitabilmente, a Platone e al Mito della Caverna.

“È quello il primo momento in cui viene teorizzata l’idea che il visivo non sia solo ciò che vediamo, ma sia anche l’interpretazione di quello che vediamo e il riflesso di quello che vediamo”. Non c’è solo Platone: anche Democrito, Pitagora, Epicuro, Lucrezio; sono i primi che hanno l’idea di un mondo che non sia più continuo (e quindi analogico) ma discreto. “Gli atomi di Lucrezio o i numeri di Pitagora, per esempio, vanno a comporre un universo complesso in cui tutti gli elementi sono correlati l’uno all’altro. Ed è proprio questa l’idea forte del digitale e dell’informatica, come della teoria del caos e della complessità. Non sono solo, ancora oggi, elementi fondamentali della scienza, ma anche del nostro modo di vedere il mondo”.