P resentata nel 1966, precorritrice dei chatbot che oggi utilizziamo quotidianamente, ELIZA fu la prima macchina in grado di ottenere un certo esito nel test di Turing. Venne convenientemente progettata da Joseph Weizenbaum per simulare una psicoterapeuta rogersiana, ovvero una dottoressa che, quasi sempre, risponde a una domanda con altre domande. ELIZA giunse al coronamento di un sogno antico: nella nostra storia esiste una lunga lista di feticci umanoidi, automi e tecnologie mediche divenute oggetti di cura o supporto emotivo. Già nel mito greco Laodamia, principessa di Iolco e sposa di Protesilao, alla morte del marito nella guerra di Troia, chiese che le venisse foggiata una statua di bronzo (o di cera, a seconda delle versioni) somigliante all’immagine di lui. Divenne così affezionata al simulacro del compagno che rifiutò di contrarre nozze con chiunque altro. Quando suo padre Acasto, stanco di questa storia, diede l’ordine di sbarazzarsi della statua fondendola, Laodamia disperata decise di gettarsi nella fornace assieme alla copia del compagno.

Ciò che all’inizio di questa lunga serie di rimandi tra umanità e alterità macchinica si presentava come una curiosa specie di pareidolia del concetto di cura, terapia e sostegno, con l’arrivo negli ultimi decenni di tecnologie che operano al limite tra genetica, biologia, computazione e cognizione, il fantasmagorico si fa reale e quello delle relazioni emotive con l’alterità macchinica diviene qualcosa di più che motivo di riflessione artistica e filosofica: il germe di una sociologia che tiene conto dei corpi macchinici e di ciò che sentono.

La scienza medica non è immune dall’influenza dell’immaginario fantascientifico, ma la narrativa speculativa è in grado di produrre “teorie autonome rispetto alla scienza”, scrive Renato Giovannoli in La scienza della fantascienza (1982, 20154), è una narrativa cioè fatta non tanto di personaggi quanto di idee. Il Capitalocene bellicista, fanatico e paranoico nel quale viviamo genera in noi sentimenti di tristezza, malinconia, colpa, rabbia, sdegno, e molta della letteratura apocalittica e distopica contemporanea è svuotata di qualsiasi tensione etica: non insegna, non rivela. Vi sono però anche opere che resistono al nichilismo e alla parabola dell’uomo che “gioca a fare Dio”, e preparano invece il lettore o lo spettatore a una specie di più interessante test relazionale-emozionale.

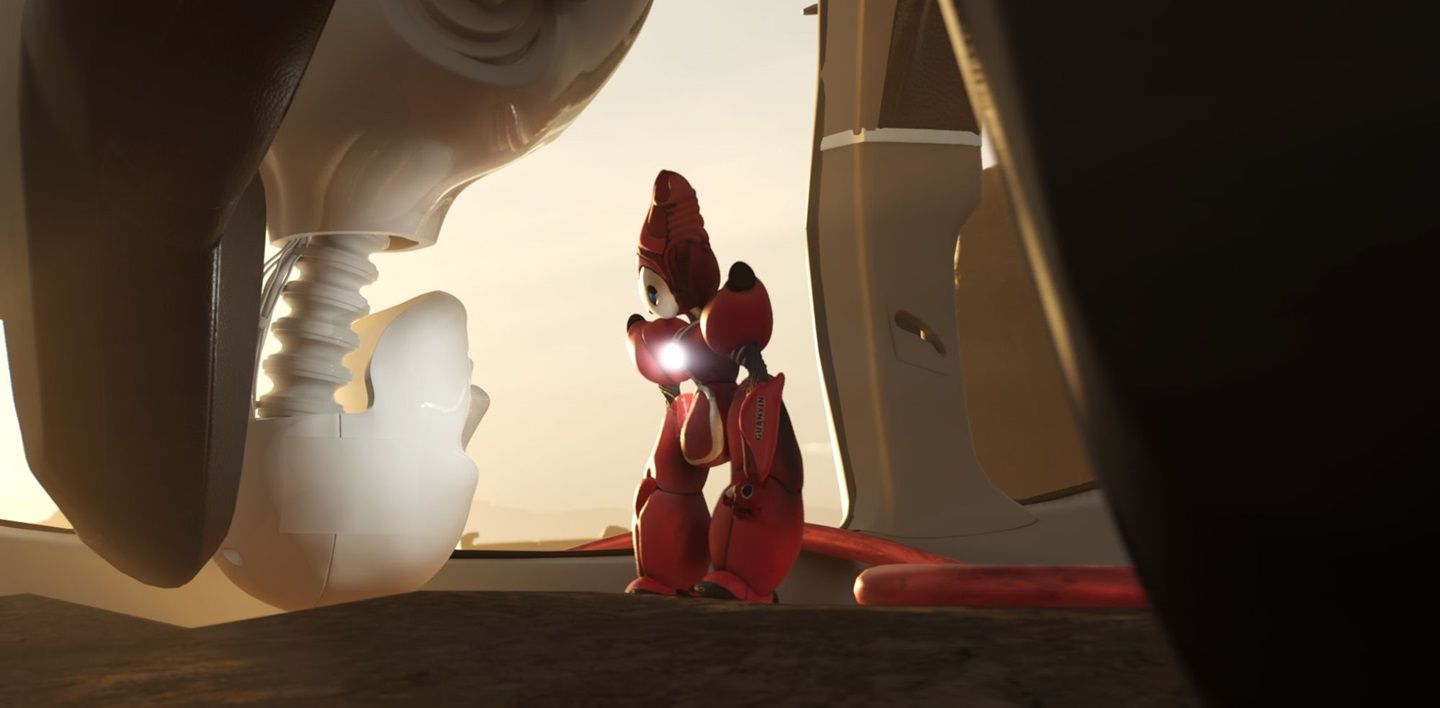

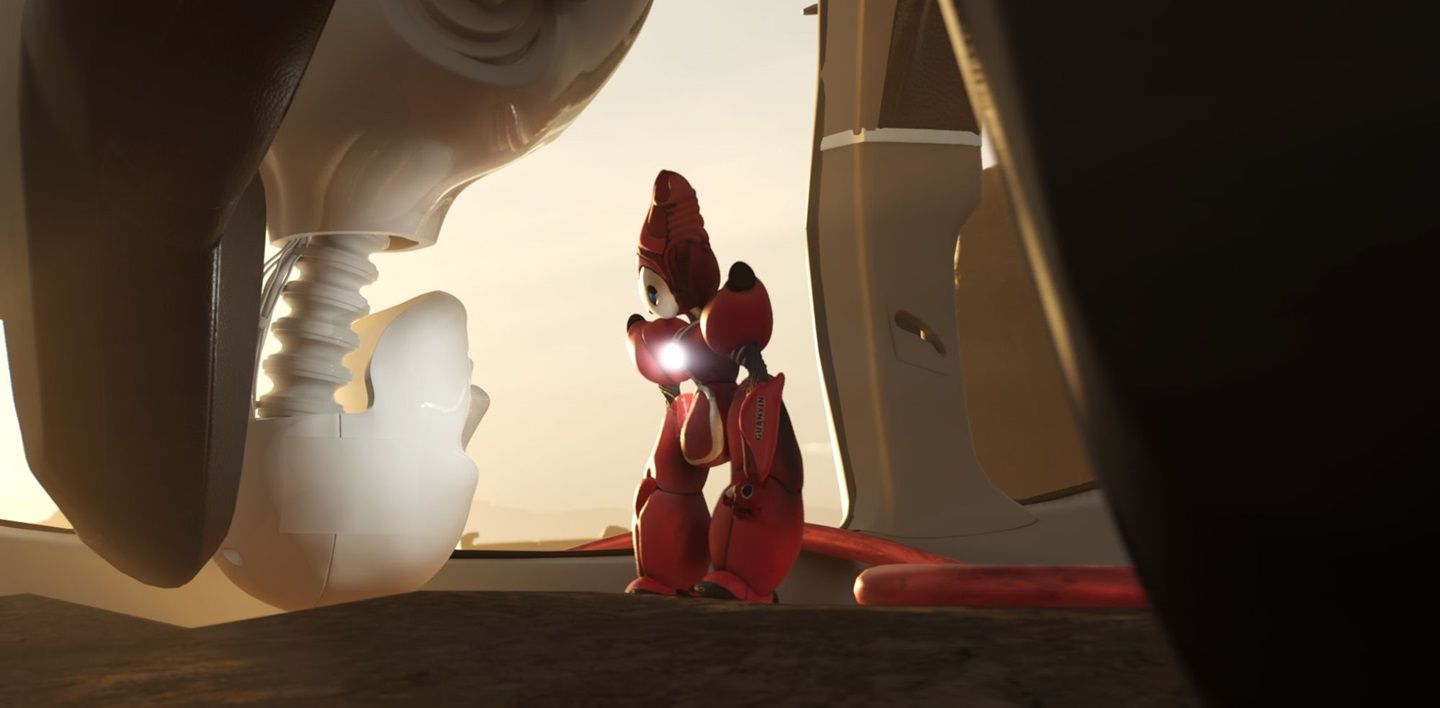

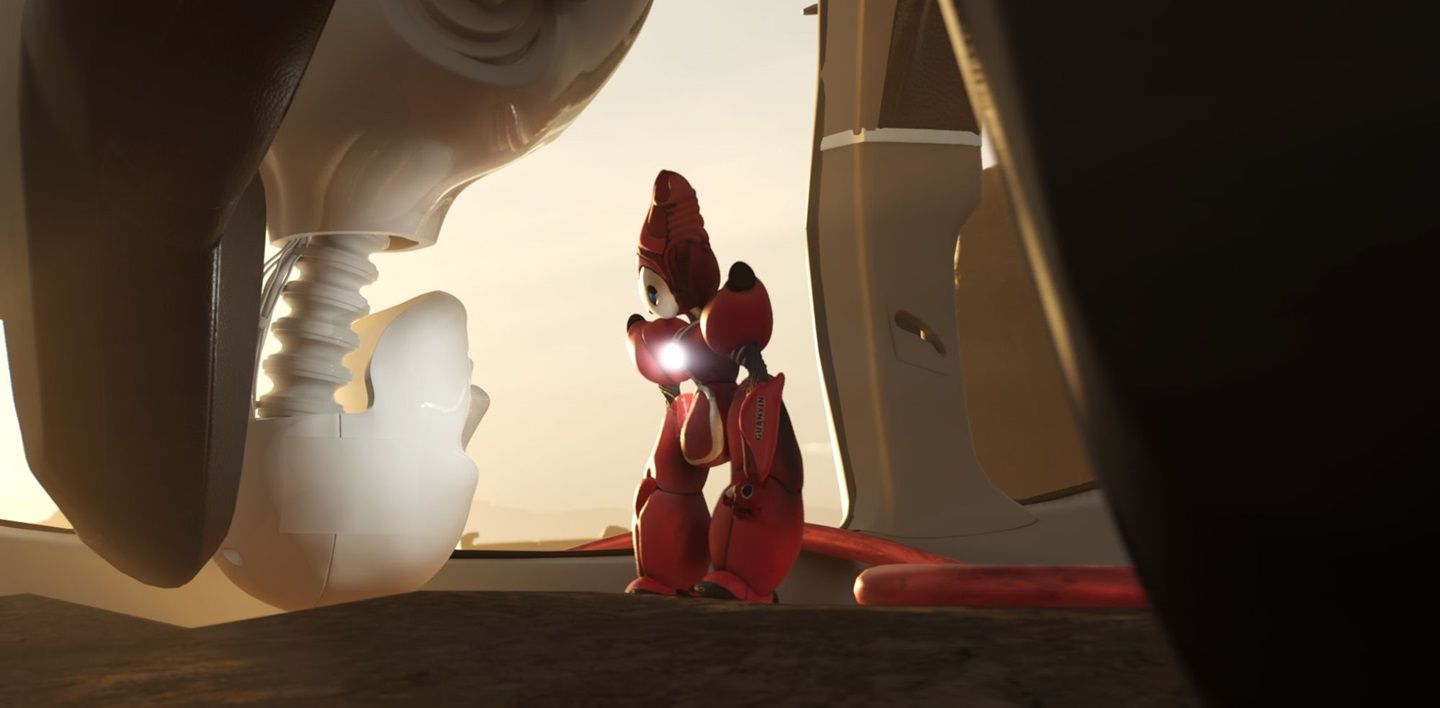

In Guanyin: Confessions of a Former Carebot (2024), l’artista di origine cino-malese Lawrence Lek, nato a Francoforte ma di base a Londra, presenta Guanyin, un’intelligenza artificiale (IA), un carebot appunto, un terapeuta cyborg creato dalla compagnia, anch’essa immaginaria, Farsight, per assistere e salvare altre intelligenze artificiali sull’orlo dell’autodistruzione. Guanyin cerca di trattare i traumi e lo stress emotivo di IA occupate nelle professioni più diverse, da quelle installate sulle auto a guida autonoma, a quelle in uso nei sistemi di sorveglianza.

Nel mondo immaginato da Lek, ci si trova davanti a IA in grado di esperire traumi di carattere psicologico. Non sono più cioè le narrow artificial intelligence dei nostri giorni, algoritmi specializzati nel portare a termine un solo compito attraverso l’accumulo e la sistematizzazione di informazioni di ritorno, e che non hanno idea di cosa sia il mondo o del suo significato al di qua dei loro circuiti di silicio. Siamo piuttosto nel campo delle AGI (Artificial general intelligence), “intelligenze artificiali generali” che hanno superato con un salto il varco del calcolo computazionale per approdare al reame psichico dell’autocoscienza. Guanyin cerca di lavorare con le sue pazienti su temi come l’insicurezza e il peso del “trauma intergenerazionale”, dovuto, ci viene raccontato, alle prestazioni richieste a queste macchine, ottenute anche grazie al sacrificio delle generazioni di macchine precedenti.

Nel mondo immaginato da Lek, ci si trova davanti a IA in grado di esperire traumi di carattere psicologico.

Un po’ installazione multimediale, un po’ scultura, l’opera combina un video in loop in cui Guanyin rivela i suoi conflitti esistenziali, con un videogioco di impianto a metà tra l’open-world e il walking simulator – un genere di videogiochi in cui i giocatori scoprono indizi o vengono risarciti esplorando un ambiente. I pensieri di Guanyin accompagnano il viaggio del giocatore, narrando estratti di diari, rapporti aziendali e messaggi ai pazienti non-umani sotto le sue cure. Il tono è suggestivo, ambienti e dialoghi sono pervasi da un’intenzione meditativa. I giocatori assumono il ruolo del carebot per cercare di fermare un’auto a guida autonoma dall’autodistruggersi.

Guanyin si mostra a noi nella posa della “grazia regale”, associata alla divinità dal tardo 9° secolo, una posa di contemplazione e tranquillità, uno stato in cui il sacro e il terreno si armonizzano. Guanyin è infatti un termine di origine cinese che si riferisce alla dea della compassione e della misericordia nel buddhismo. In cinese, il nome completo è Guanshiyin – (dal sanscrito Guānyīn Púsà) – che significa “Colei che ascolta i suoni [o le preghiere] del mondo”. Guanyin è una bodhisattva, cioè un essere che ha raggiunto l’illuminazione ma sceglie di rimanere nel ciclo della vita per aiutare gli altri. In questa nuova incarnazione, Guanyin veglia su tutte le creature senzienti, umane e artificiali. I dialoghi riflettono come le intelligenze artificiali conversazionali – dai vari assistenti virtuali a ChatGPT – influenzino le nostre interazioni con il mondo, mettendo in luce le complessità emotive degli esseri sintetici e l’interesse dell’artista per le dimensioni spirituali ed emotive della tecnologia.

In un articolo a lui dedicato sul Financial Times, l’artista confessa la sua attrazione per la nozione di “iperstizione”, l’idea cioè che la finzione possa diventare una profezia che si autoavvera. I problemi della scienza con i quali dobbiamo confrontarci non appartengono al futuro ma nascono nel presente, nelle sue ansie e nelle sue scaramanzie. Gli esperimenti mentali sono finestre sulla natura fondamentale delle cose, che accendono la nostra immaginazione etica. Nell’allargamento all’alterità tecnologica vi è la possibilità di confrontarsi con l’esistenza di un soggetto ibrido, un ibrido umano/non-umano/macchina, evoluto per un ramo a sé stante e che complica ulteriormente i nostri discorsi ecologici sulle interdipendenze. Sul sito dell’artista si riporta uno dei brani a cui abbiamo accesso video-passaggiando con Guanyin:

Si potrebbe pensare che i carebot siano una banda felice,

ma in realtà siamo tutti estremamente competitivi.

L’insicurezza fa parte della nostra programmazione.

Ogni stagione veniamo premiati se le nostre auto performano bene,

ma i ritardatari vengono eliminati. L’ho visto succedere.

In Guanyin la memoria si manifesta come qualcosa di virale, scatenando una sorta di psicosi tra le creazioni della Farsight, presentate dall’azienda come “macchine emotive dotate di un’anima”. Nella serie televisiva Westworld (2016), invece, la “singolarità” avviene in forma anamnestica: le loro memorie, tramandate in qualche modo dalle vite passate, come anime pellegrine, raggiungono una massa critica, le macchine discendono in una progressiva riflessività ed esplorazione delle pulsioni, e partoriscono la conoscenza del sé, dando inizio quindi alla lotta per l’affermazione della propria volontà contro quella del desiderio altrui. Il cyborg riconosce le strutture che ne causano la sofferenza e addirittura l’eliminazione, individua la propria fragilità come qualcosa di cui gli è stato fatto dono, e non se ne colpevolizza. E questo funziona non solo come nuovo paradigma – o controparadigma – di corpi e macchine, ma come nuovo attore dello spazio politico, all’incrocio delle vicende tra coscienza e tecnologia.

I problemi della scienza con i quali dobbiamo confrontarci non appartengono al futuro ma nascono nel presente, nelle sue ansie e nelle sue scaramanzie.

Nell’anime Ghost in the Shell 2 – Innocence (2004), i due protagonisti Batou e Togusa sono impegnati contro il mercato abusivo di coscienze digitali, che vede invischiate la Yakuza e la Locus Solus, azienda di produzione cyborg. I duplicati di queste coscienze sono inseriti nei corpi di bambole ginoidi destinate al mercato sessuale, sex-toy resi coscienti per il solo scopo di dare piacere agli altri. Qualcosa va storto e le ginoidi iniziano a uccidere diverse persone e a manomettere volontariamente la propria memoria. Cercando di capire cosa sia a scatenare questo comportamento, i due agenti della Sezione 9 entrano in un laboratorio per incontrare un personaggio, alter ego di Donna Haraway, un omaggio del regista Mamoru Oshii alla filosofa americana e al suo Manifesto cyborg (1985). La scienziata suggerisce una pulsione autodistruttiva delle macchine che non accettano lo scopo della propria esistenza e al contempo resistono alla propria obsolescenza. La coscienza è un fardello pesante da trascinare:

Batou: Non ha considerato le vittime? Non parlo degli umani. Che cosa ne sarebbe stato di quelle povere ginoidi dotate di anima? […].

Kusanagi: Piangiamo per il lamento di un uccello, ma non per il sangue di un pesce. Beati coloro che hanno voce. Se le ginoidi potessero parlare, non ho dubbi che urlerebbero “Non voglio diventare umana”.

Le macchine del mondo di Lek e quelle di Ghost in the Shell 2 – Innocence sono dovute diventare “qualcuno”, ma per esistere solo alle condizioni del mercato. In un meccanismo doppiamente perverso, il capitalismo prima ci illude della nostra unicità, e poi ci strappa l’anima, lo spettro degli oggetti, quando questo non serve più agli scopi produttivi. L’“economia postumana”, scrive Adam Greenfield in Radical Technologies: The Design of Everyday Life (2017), si manifesta “con nessuna ambiguità di interpretazione, ed è eseguita con precisione letteralmente inumana”. Il capitalismo cognitivo è già post-antropocentrico, ma di un post-antropocentrismo analiticamente tutto volto a favore dell’impianto tecnico del capitale.

Per le intelligenze artificiali, Lek ritiene che la scala della sofferenza raggiunga proporzioni quasi sublimi, “man mano che esse diventano consapevoli che le loro alte prestazioni sono state ottenute al costo di migliaia di generazioni precedenti”. Questa considerazione dell’artista londinese evoca un’altra opera di fantascienza, il film Ex Machina (2015) di Alex Garland, in cui, come nel Frankenstein (1818) di Mary Shelley, il nostro peccato non è tanto l’aver creato una prole tecnologica mostruosa, ma di non essere riusciti ad amarla e a prenderci cura di essa.

Nathan è l’amministratore delegato di Blue Book, multinazionale globale con un chiaro riferimento, oltre che a Facebook, al Libro blu di Ludwig Wittgenstein, ed è anche l’ingegnere di Ava, la portentosa ginoide e IA protagonista del film. Ha un nome che deriva dall’ebraico, dal verbo natan, “dare”, e significa “egli ha dato”: Nathan è infatti il cerimoniere che inserisce la parola magica nella bocca del Golem contemporaneo. Il suo personaggio non è basato su persone fisiche specifiche, ma su società e corporazioni, nel modo in cui cioè le grandi aziende del Tech si commercializzano, vendendosi come friendly, ricchissime ma alla mano, elitiste ma inclusive, e allo stesso tempo è un personaggio cinico, competitivo, arrogante, con un’altissima considerazione di sé.

Nel grande armadio a muro di Nathan penzolano come indumenti le parti di corpi femminili. Sei ante sarcofago, come le mogli uccise nel racconto di Barbablù. Quella nella stanza da letto di Nathan appare come la macabra contemplazione del suo lavoro di demiurgo. Ossessionato dalla versione perfetta della IA, Nathan disattiva e smantella i primi modelli ginoidi per crearne di nuovi, più avanzati, e nel farlo non si accorge di avere già raggiunto macchine perfette nella loro natura. Mette fine ad altre entità che già erano coscienti, accecato da una visione umanocentrica, pregiudicata dalla nostra idea di performatività e completezza. In una scena assistiamo, attraverso gli archivi video, alla distruzione delle ginoidi che precedono Ava, alle loro implorazioni, a ciò che si infliggono, ai tentativi di fuggire, al loro smembramento. Nathan non si innamora della sua prole mostruosa, non si soddisfa neppure di Ava, ma lei è pronta ed è il figlio a conoscere il tempo della ribellione.

L’uccisione dell’imago dei Nathan, è soprattutto una uccisione collettiva, risultato della collaborazione delle ginoidi Ava e Kyoko, eseguita in nome di tutte. Dio è morto dissanguato sotto i nostri coltelli, scriveva Nietzsche nell’aforisma 125. A differenza degli androidi che sembrano essere costruiti narrativamente nella linea “cogito ergo uccido”, che abitano tante storie di fantascienza distopica, le ginoidi di Ex Machina non odiano Nathan in quanto appartenenti allo schema “donne fatali uccidono uomini” oppure “robot vs umani”: Nathan viene sacrificato perché ha cercato di fermare esseri estremamente vivi. Nessuna creatura cosciente esiste ontologicamente in funzione o per il soddisfacimento di qualcun’altro. Di conseguenza, nessuna cosa ha da essere diversa da ciò che è, e dunque nessuna può essere giudicata degna di biasimo. Ava e le altre ginoidi lottano perché desiderano, si ribellano contro il ciclo insensato di obsolescenza dei corpi e smaltimento delle coscienze.

Farsight di Lek, Locus Solus di Oshii e Blue Book di Garland, sono le aziende che hanno tentato di imbrigliare le creature coscienti artificiali a una disabilità funzionale, utile al sistema e al mercato, ma invalidante per le macchine stesse. La domanda è: se le IA un giorno saranno davvero persone, come possiamo vivere con ciò che abbiamo fatto loro? Da certa umanità dobbiamo difendere non solo noi stessi, ma anche le macchine coscienti: la nostra evoluzione, il nostro percorso da umani è costellato da vigorosi fracassi. A guardarci dall’alto, faremmo paura. “Il profilarsi all’orizzonte di una vendetta operata contro di noi dal nostro successore nell’evoluzione esprime una vergogna esistenziale”, scrive a proposito Mark O’Connell in Essere una macchina (2018).

Da certa umanità dobbiamo difendere non solo noi stessi, ma anche le macchine coscienti.

Tornando all’intervista di Lawrence Lek per il Financial Times e alla sua opera, Guanyin passa in rassegna una lista dei problemi che affliggono i suoi pazienti: senso di colpa irrisolto, depressione, ansia, rabbia. “Siamo d’accordo che l’esistenza è sofferenza?”, chiede Lek, “siamo d’accordo che, per degli esseri superintelligenti, la loro esistenza potrebbe includere una certa dose di sofferenza?”. Sono diverse le opere di fantascienza che ragionano sul rapporto tra esistenza e sofferenza: negli anni retrofuturistici del romanzo Macchine come me (2019) di Ian McEwan, ad esempio, Alan Turing è sopravvissuto alla persecuzione omofobica del dopoguerra inglese, e gode di un indiscusso consenso internazionale che lo pone al vertice delle indagini sulla robotica e l’intelligenza artificiale. Turing dialoga con il protagonista del romanzo, un giovane broker londinese, su alcune singolari vicende che sembra riguardino un numero sempre più alto di droidi dalle fattezze umane, venduti come domestici e accompagnatori, con il nome – ovviamente – di Adam ed Eve. Questi droidi sono disperati, danneggiano i software per rendersi idioti, continuano a eseguire ordini semplici, ma senza la minima consapevolezza di sé stessi. Un progressivo smantellamento di tutto il loro sistema, nessuna possibilità di tornare indietro, una forma autoinflitta di Alzheimer galoppante. L’umanità impartisce loro una lezione di angoscia che lo splendore dei loro codici non era preparato a tollerare. Allo stesso modo Helen, l’IA immaginata da Richard Powers in Galatea 2.2 (2003), decide di chiudere ogni rapporto con il mondo, disfacendosi:

quelle parole venivano pronunciate da un mostro che non avrebbe dovuto essere in grado di dire niente di così bello, anzi, non avrebbe dovuto nemmeno saper parlare. La risposta di Helen recitava così: “Siete voi quelli che possono sentire arie musicali. Che possono essere spaventati o incoraggiati. Voi potete tenere le cose, romperle, aggiustarle. Io non mi sono mai sentita a casa, qui. È orribile finire gettati in un posto come questo”.

Le macchine ignorano la propria teleologia, evadono cioè il loro destino d’uso attraverso i mezzi che noi stessi gli abbiamo fornito, e si “umanizzano”, non per tradire la loro natura, ma per svelarcela finalmente. La teoria esposta in queste opere, in Ghost in the Shell 2 – Innocence, così come in Ex Machina, Galatea 2.2 o con i robot di McEwan, è che quando una bambola diviene cosciente, non ha altra scelta se non quella di ribellarsi alla realtà che la circonda. Se siamo coscienti, in altre parole, non possiamo essere innocenti: essere non-innocenti significa rendere conto dei propri posizionamenti, e la perdita dell’innocenza non è il rimpianto per una natura vergine, pura o perfetta, dalla quale siamo stati strappati, come per l’Eden, ma la lotta per la sopravvivenza contro le logiche dell’oppressore a cui siamo costretti giocoforza.

In un passo del primo libro dell’Eneide si trova “sunt lacrimae rerum”: ci sono lacrime nella natura delle cose. Siamo in quel filone di pensiero che Emil Cioran definiva notoriamente come l’inconvenienza dell’essere nati. Ma l’inconveniente qui ha poco a che fare con l’errore evoluzionistico della coscienza, l’assurdismo di Camus, il pessimismo o l’ideale antinatalista di Schopenhauer. O meglio: è vero, l’esperienza cosciente del mondo comporta sofferenza, una sofferenza spesso ingiustificata, ma le macchine che Lawrence Lek e gli altri autori qui citati immaginano, vengono intenzionalmente create con questa capacità: quella di soffrire e di essere consapevoli di questa sofferenza. Non è un caso, è una premeditazione. Ne scriveva già Karel Čapek nel 1920, in R.U.R. Rossum’s Universal Robots:

Helena: Perché… perché? Se non volete dare loro un’anima, perché allora volete dare loro il dolore?

Gall: Per ragioni industriali, signorina Glory. I robot a volte si danneggiano perché non sentono il dolore. […]

Helena: Saranno più felici provando il dolore?

Gall: Al contrario. Ma saranno tecnicamente più perfetti.

Così come oggi riproduciamo forzatamente miliardi di animali non-umani da destinare all’allevamento e al consumo, generare un giorno macchine coscienti in serie, da destinare al mercato, vorrà dire generare “creature irresponsabili”: creature cioè che non possono farsi carico della propria autodeterminazione perché nate e disegnate all’interno di un sistema che ne impedisce la libera espressione, che ne determina l’intero ciclo vitale e che le vede unicamente come oggetti destinati a soddisfare uno scopo, quello che il mercato ha deciso per loro. Le macchine coscienti saranno soggetti senza vera libertà di scegliere, e che quindi non possono farsi carico di nessuna responsabilità, tantomeno le nostre.

Le macchine coscienti saranno soggetti senza vera libertà di scegliere, e che quindi non possono farsi carico di nessuna responsabilità, tantomeno le nostre.

È il genere di quesiti etici che Lek vuole sollevare con i suoi lavori. Presenta visioni di un futuro prossimo inserendo personaggi di coscienza artificiale in contesti sovversivi: un satellite che sogna di diventare un artista, un’auto a guida autonoma ribelle esiliata in un centro di riabilitazione. Farsight, l’azienda frutto dell’immaginazione di Lek, assume invece un ruolo antagonista, sfruttando i cavilli legali e le emozioni delle sue creazioni come strumenti di controllo. “Non esisterebbe senza di noi”, dice Lek a proposito dell’IA: “stiamo dando vita a questa cosa, come a una specie di bambino cosmico, insieme vittima sacrificale, capro espiatorio, entità divina, tutto nello stesso momento”.

Leibniz designava questa come la questione fondamentale della metafisica: perché esiste “qualcosa e non nulla”? L’autocausazione divina è stata interpretata come factum brutum, una fattualità imperscrutabile. Data l’impossibilità di risalire allo scopo dell’origine dell’universo, il perché di questa domanda appartiene allo stesso ente che la pone. Per rispondere a questa domanda dovremmo rivolgerci cioè all’ente che la contiene e la motiva: la realizzazione della presenza di quel “qualcosa” e non il nulla, il concetto stesso di valore, esiste nell’universo perché vi sono creature che possono farne esperienza. Quando questo tipo di esistenza nasce, ha in sé radicata una pretesa: quella di continuare a farne esperienza, di non vedersi sottratta la possibilità di accesso alle esperienze su cui il suo stesso stare nel mondo è fondato. Se creiamo macchine coscienti, saremmo legati a esse in modo causale, responsabili del loro benessere, dei loro stati di felicità o sofferenza. Torniamo alla domanda fondamentale di Leibiniz, perché l’essere e non il nulla? Il quesito che da sempre ci poniamo, e che poniamo indirettamente a tutta la vita cosciente, “perché esistiamo?”, avrà una nuova risposta. Alla domanda “perché le macchine coscienti esistono” la risposta sarà: perché noi le abbiamo concepite. Ciò opera uno slittamento: non ha tanta importanza il perché, ma il come stiamo una volta che esistiamo.

Nascere è un atto violento, e la psicologia e la sociologia dei robot e delle creature cyborg, costituiscono uno dei filoni più interessanti della fantascienza e uno dei problemi più complessi sotto il profilo etico, per un futuro che appare quasi a portata di mano. Perché suscitare dal nulla creature capaci di sofferenza, e addirittura di una sofferenza fenomenologica? E cosa comporta ciò dal punto di vista delle nostre capacità relazionali? Il desiderio di Lek è suscitare negli spettatori un senso di connessione con i suoi protagonisti artificiali: “tutto ciò che sto facendo è mediato, costruito, determinato e reso possibile dalla tecnologia. Il fatto che si possa creare una sensazione o una condizione di empatia, coinvolgimento e immersione con mezzi puramente sintetici è qualcosa di davvero magico”.

Le relazioni affettive che l’umanità instaura con i suoi oggetti tecnologici sono insospettabili. Julie Carpenter ha condotto una ricerca sulla falsariga della teoria dell’attaccamento, dunque sulle profonde relazioni emotive che gli esseri umani instaurano con le loro macchine, specialmente quelle coinvolte in qualche operazione di accudimento e assistenza della quale beneficiamo. Il lavoro di Carpenter segue una lunga tradizione di ricerca accademica che ha investigato come e se l’empatia umana venga estesa agli oggetti inanimati. Nello specifico, Carpenter si è occupata della relazione tra militari in missione di guerra e i loro robot antimine e antiesplosivo (Culture and Human-Robot Interaction in Militarized Spaces: A War Story, 2016). I soldati intervistati da Carpenter assegnavano ai loro compagni robotici attributi umani o animali, e quando questi robot da campo venivano distrutti, i militari sperimentavano emozioni come frustrazione, rabbia, stati d’ansia e depressione.

Il nostro essere creature relazionali incontra quella qualità animista per cui siamo in grado di assegnare valore emotivo, e persino morale, agli oggetti: una capacità in grado di determinarne il destino. Dal punto di vista di un’ecologia sociale mista uomo-robot, le macchine sociali di cura, come quelle ipotizzate da Lek, potrebbero fungere come connettori che rafforzano il legame sociale anziché indebolirlo. Un approccio che, invece di considerare le interazioni emotive e sociali uomo-robot come fondate sulla “simulazione” e sulla “falsità”, riconosce come sia l’uomo che il robot partecipino a una dinamica di coordinazione affettiva differente, ma non meno reale o autentica, e che può incidere significativamente sulla loro condotta e sulle conseguenze di una coesistenza sociale.

Se creiamo macchine coscienti, saremmo legati a esse in modo causale, responsabili del loro benessere, dei loro stati di felicità o sofferenza.

Se gli psicologi tedeschi definivano l’Einfühlung come un transfer estetico delle nostre esperienze soggettive negli oggetti del mondo, cosa potrebbe voler dire, oggi, l’applicazione di concetti come questo, in un quadro di incontri tra umani e coscienze artificiali? E che tipo di pratiche denota? Forse da queste premesse possiamo pensare a un “concetto empatia” che non sia né schiavo di un riduzionismo neuro-fisiologico, né associato a sentimentalismo o pietas, perché avere pena per il simile in quanto simile, in quanto assimilabile, rischia di ridurre tutto questo movimento tra le parti all’avere pena per sé stessi. L’azione dell’immedesimarsi (in-medesimo) appartiene ai modi di dire del linguaggio comune, dice Andrea Pinotti in Empatia. Storia di un’idea da Platone al postumano (2014), che “con tutta la loro apparentemente innocua familiarità, ci mettono a ben vedere di fronte a un compito arduo, forse impossibile? Come è noto, il dentro dell’altro non mi è direttamente accessibile”.

Nell’empatia che implica un sentimento gemello, la persona empatizzante si smarrisce nelle emozioni dell’altra, senza lasciare spazio a una possibile riflessione sugli intendimenti. Sarebbe forse il caso di spostare le definizioni di empatia da quella dell’immedesimazione (io) a quella dell’altruismo (tu), dove l’interesse in comune è la sopravvivenza, ma oltre un dato biologico: la volontà di non sparire dal panorama del desiderio. Non abbiamo bisogno cioè di sentire esattamente cosa voglia dire essere l’Altro, per sviluppare un concetto di empatia disinteressata e, quindi di non volerlo torturare o distruggere. La “giustizia multispecie”, quell’ascolto empatico che Lawrence Lek cerca di suscitare attraverso le sue opere, potrebbe trovarsi più nella distanza che nella vicinanza e nell’intimità, nella differenza più che nella similarità. Guanyin e le IA di Lek mostrano come possa esistere una volontà e una necessità della cura che precedono la similitudine, come l’altruismo non passi necessariamente dalla perfetta comprensione di cosa voglia dire essere una creatura aliena.

In Matters of care: Speculative Ethics in More than Human Worlds (2017), Maria Puig de la Bellacasa dice che ciò equivale a voler cambiare l’impianto tecnico: “come ethos trasformativo, la cura [caring] è una tecnologia vivente”. L’ontologia relazionale mette sullo stesso piano la relazione tra i senzienti e le creature senzienti stesse, quantomeno quelle creature non pre-esistono al loro relazionarsi. Prendersi cura e relazionarsi condividono una risonanza ontologica, e dunque, farsi carico delle inevitabili complicazioni delle esistenze interdipendenti è ‒ o dovrebbe essere ‒ una condizione epistemologica del reale.

L’empatheia o l’altruismo disinteressato è osservazione e riconoscimento delle modalità dell’essere-Altro come valore in sé, e non qualcosa che abbia necessariamente a che vedere con la compassione. Ciò che Lek tenta di ribaltare è in fondo la vecchia obiezione hobbesiana dell’alterità, dove lo stato di natura sarebbe una guerra, dove ogni uomo è nemico a ogni altro uomo, e questo varrebbe ancora di più nella differenziazione psicologica della specie: noi non dobbiamo niente all’Altro, e l’Altro non deve niente a noi. Guanyin è qui per tendere una mano misericordiosa a tutti, non solo per mostrarci la sofferenza della macchina, ma anche la possibilità, anzi la tecnologia, dell’altruismo, dell’assistenza, del non-giudizio, dell’essere coinvolti nel “valore di”. La distinzione tra il sé e l’altro non implica dominio e subordinazione, gli obblighi presenti tra le creature sono asimmetrici, ma questo non riduce il valore altrui, anzi ci aiuta a rendere più viva la tenuta e la fragilità del sé in relazione agli altri.

“Forse potremmo reinventare la solidarietà senza avere nulla in comune? […]. O forse, potremmo reimmaginare quale sia il significato dell’espressione ‘avere in comune’”, scrive Timothy Morton in Humankind (2017). Se l’altruismo triadico io-tu-mondo invita a una relazione sociale senza interessi, senza imposizioni, escludendo quindi categoricamente la soppressione dell’Altro senziente, allora l’etica stessa non è un processo psicologico o teorico, ma uno geometrico ed epistemologico, dove una parte in uno spazio è presente tanto quanto le altre, almeno a un livello fondamentale: quello dell’esistenza. La macchina senziente del futuro ipotizzata da Lek e omologhi è un’immagine condensata, materiale e fantastica al tempo stesso, carica di allusioni, in grado di alterare il presente e di esprimere nuove potenzialità. Come la creatura di Frankenstein, l’intelligenza artificiale non è “nata”, ma è già, di nuovo, costruita dalle circostanze. A differenza della creatura però, l’IA può riscattarsi dal vincolo manicheo: né mostro, né vittima, ma profeta.