C ostretti a lavorare senza sosta, privati di qualunque forma di libertà e sopprimibili a nostra discrezione. E se l’uomo, senza neanche rendersene conto, stesse per dare vita a una nuova forma di schiavitù, le cui vittime non sono più esseri umani o animali, ma robot e software intelligenti? La domanda sembra assurda. La prospettiva che un giorno possa emergere una forma di intelligenza artificiale in grado di agire e ragionare a un livello pari a quello dell’essere umano è al momento ancora remota, è vero. Eppure già oggi c’è chi si dedica ad affrontare temi che sembrano usciti da film come Ex Machina o Westworld.

“Consideriamo, per esempio, lo scenario di un team di IA di livello umano (…) che siano confinate in una realtà virtuale e obbligate a lavorare come schiavi (…)”, scrive il professore di Robotica cognitiva Murray Shanahan in La rivolta delle macchine (LUISS University Press, 2018). “Si supponga che a queste IA fosse impedito di fare qualsiasi altra cosa che non sia lavorare a problemi determinati dai loro possessori e padroni umani. (…) Dopo aver lavorato per un po’, le copie più promettenti vengono tenute; quelle che non hanno lo stesso successo vengono invece terminate. Se queste fossero lavoratori umani, condizioni del genere verrebbero considerate più che brutali. Le IA non hanno vita oltre il lavoro, e vengono costantemente minacciate di morte se operano in maniera insufficiente”.

Rispetto a questo scenario, ciò che oggi ancora manca è un grado di sofisticazione tale da farci sospettare che i software possano essere considerati alla stregua di individui o persone. Ma come faremo ad accorgerci di aver oltrepassato il limite? Quand’è che un’intelligenza artificiale non può più essere trattata come un semplice oggetto?

L’inconveniente di essere nati

Seguendo la linea di pensiero del filosofo Jeremy Bentham (ripreso proprio da Shanahan), il nostro dovere morale nei confronti delle intelligenze artificiali sottoposte a forme estreme di schiavitù dovrebbe scattare solo ed esclusivamente dopo aver risposto a una domanda: possono soffrire? Ciò su cui dobbiamo interrogarci, quindi, non è quanto queste IA siano in grado di effettuare ragionamenti complessi, e neanche se siano o meno in grado di parlare, ma solo ed esclusivamente se possano soffrire; una condizione che presuppone che questi software e robot siano dotati di una caratteristica particolare: la coscienza.

“Se le IA fossero ‘automi senza cervello’ alle quali manca una coscienza, e con essa la capacità di soffrire, tutto ciò non avrebbe importanza”, scrive sempre Shanahan. Sviluppare una forma di coscienza è quindi il prerequisito per poter soffrire, che a sua volta è la condizione necessaria perché si possa considerare lo sfruttamento delle intelligenze artificiali come una forma illegittima di schiavitù. Messa così, la questione sembra presto risolta: perché mai dei software dovrebbero avere coscienza? Possiamo tranquillamente continuare a insultare Siri e a far lavorare come uno schiavo il nostro robot-aspirapolvere; in attesa, un domani, di sfruttare senza sosta il nostro assistente virtuale, ormai talmente evoluto da fare concorrenza alla intelligenza artificiale con la voce di Scarlett Johansson vista in Her di Spike Jonze. Oppure no?

Quello su cui interrogarci non è se le intelligenze artificiali siano in grado di effettuare ragionamenti complessi, ma se possano soffrire.

“Tre attributi cognitivi che sembrano essere non solo necessari per avere una coscienza, ma anche strettamente correlati sono: (1) un senso di scopo manifesto, (2) una consapevolezza del mondo e di quanto succede, (3) la capacità di integrare conoscenza, percezione e azione”, si legge in La rivolta delle macchine. È infatti attraverso questi tre attributi cognitivi che siamo in grado di attribuire una coscienza a buona parte delle forme di vita animali presenti sulla Terra: “Quando vediamo un animale che dà la caccia a un altro (come un gatto con un topo), immediatamente attribuiamo un senso di scopo a entrambi: un animale vuole acchiappare l’altro, e l’altro vuole scappare. (…) Un animale manifesta una consapevolezza rispetto a ciò che lo circonda quando percepisce la situazione in atto e a essa reagisce in maniera coerente con i propri obiettivi e desideri (…). Infine, un animale dimostra una completa integrazione cognitiva quando le sue azioni non solo sono coerenti con quanto percepisce di ciò che lo circonda, ma anche con quanto percepito in passato e con quanto ha imparato di conseguenza”.

In poche parole, nel momento in cui un essere (naturale o artificiale che sia) si dimostra in grado di manifestare il proprio scopo, di avere consapevolezza di ciò che lo circonda e di poter utilizzare le sue conoscenze pregresse per agire con accresciuta efficacia, tutto ciò significa una cosa sola: siamo in presenza di un essere dotato di coscienza. E le intelligenze artificiali? “Gli aspirapolvere robot o le automobili senza pilota mostrano entrambi un certo grado di consapevolezza rispetto all’ambiente circostante, e sono in grado di rispondere agli eventi in corso in maniera coerente con i propri principi elementari”, prosegue Shanahan. “Gli assistenti personali virtuali non danno la stessa impressione di autonomia o di scopo, però possono integrare informazioni di vario tipo da fonti differenti, comprese le abitudini di navigazione, i dati GPS, le voci in agenda e così via. Con la convergenza e complessità via via crescenti di queste tecnologie, diventerà più completa l’illusione che ci sia un’entità simile a una mente dietro a uno schermo e una voce. E allora, questa IA superintelligente? È difficile vedere come un sistema potrebbe possedere un’intelligenza forte, per non parlare di una superintelligenza, a meno che non esibisca quei tre attributi cognitivi”.

Le intelligenze artificiali mostrano già oggi, almeno in parte, gli attributi che determinano la presenza di una coscienza; e con l’evoluzione di questi sistemi diventerà sempre più difficile archiviare la questione “coscienza dei robot” con un’alzata di spalle. C’è però un aspetto chiave ancora da affrontare, riassunto nella parola “illusione” utilizzata da Shanahan: come possiamo essere sicuri che un’intelligenza artificiale estremamente evoluta, in grado di sfruttare l’esperienza, di avere consapevolezza di ciò che lo circonda e di agire con un chiaro senso di scopo non stia solo simulando di possedere tutte queste caratteristiche (rispondendo invece solo a ciò che è inscritto nel suo codice)?

Fa male quando ti sparano?

Nel momento in cui una self driving car sceglie in autonomia la strada migliore per arrivare a destinazione, reagisce agli imprevisti che si presentano lungo il percorso e utilizza quanto appreso nei tragitti precedenti per ridurre al minimo il rischio di incidente, siamo in presenza di un essere cosciente o ne abbiamo solo l’illusione? E se vi sembra una domanda dalla risposta scontata, che dire di un robot maggiordomo che si muove con sicurezza nel nostro appartamento, conosce a memoria i nostri gusti e le nostre abitudini, risponde a tono ogni volta che interloquiamo con lui e manifesta esplicitamente il suo desiderio di servirci nel modo migliore; in questo caso, siamo di fronte a un essere dotato di coscienza o davanti a qualcosa che, più semplicemente, sembra solo esserne dotato?

Questa domanda apre le porte a ciò che Shanahan chiama il “problema difficile” della coscienza, la “difficoltà di spiegare in termini scientifici perché una creatura cosciente è un qualcosa (per usare la terminologia di un altro filosofo, Thomas Nagel). Come mai abbiamo sensazioni ed emozioni soggettive? Come mai l’esperienza visiva soggettiva che sto avendo in questo istante (…) riesce a manifestarsi nel mio cervello? Il problema, in questo caso, sorge quando guardo con sospetto i miei compagni di viaggio. Quale che sia il loro comportamento, qualunque cosa facciano o dicano – anche se guardano nostalgici il panorama e commentano la sua bellezza – è sempre possibile che non stiano provando nulla. Non ho accesso al loro mondo interiore privato, quindi come faccio a essere certo che ne abbiano uno? Magari sono solo zombie, o degli automi”.

Le IA mostrano già alcuni attributi che determinano la presenza di una coscienza; con l’evoluzione di questi sistemi diventerà sempre più difficile archiviare la questione “coscienza dei robot”.

In questo modo, la questione viene ribaltata: invece di chiederci se un’intelligenza artificiale possa davvero avere una coscienza (o se stia invece soltanto simulando di averne una), la domanda da porci è come essere certi che le persone che ci circondano siano davvero dotate di coscienza o non stiano (inconsapevolmente) fingendo. È la questione del cosiddetto zombie fenomenologico: in un articolo pubblicato su Aeon, sempre Shanahan ha richiamato uno dei filosofi più citati quando si tratta di affrontare il tema della coscienza di un automa: Ludwig Wittgenstein. “Riflettendo sul fatto che un suo amico potrebbe essere un semplice automa – o uno ‘zombie fenomenologico’, come diremmo oggi – Wittgenstein nota di non poter essere sicuro che il suo amico abbia un’anima. Piuttosto, ‘la mia attitudine nei suoi confronti è l’attitudine nei confronti di qualcuno dotato di un’anima (dove per ‘avere un’anima’ possiamo interpretare qualcosa di simile a ‘essere coscienti e capaci di provare gioia e sofferenza’). Il punto è che, nella vita di tutti i giorni, non ci mettiamo a pesare tutte le prove che abbiamo a disposizione per concludere se i nostri amici o amati siano creature coscienti come noi o meno. Semplicemente, li vediamo in questo modo e li trattiamo di conseguenza. Non abbiamo alcun dubbio su quale sia il corretto atteggiamento da tenere nei loro confronti”.

D’altra parte, non possiamo chiederci ogni volta che incontriamo un essere che ci sembra intelligente se lo sia davvero o se si stia solo comportando come tale. Il punto, anzi, potrebbe proprio essere che se qualcuno è in grado di comportarsi in modo intelligente significa che è intelligente. E che quindi vada trattato come tale. Tutto questo, a maggior ragione se – rispondendo alla domanda fondamentale di Nagel – non possiamo negare alle macchine nemmeno la possibilità di provare dolore: “In una scena di Terminator 2, John Connor chiede al suo protettore robot: ‘Fa male quando ti sparano?’. Terminator risponde: ‘Percepisco un infortunio, questo dato può essere chiamato dolore’. Materialisti come Thomas Hobbes sarebbero stati d’accordo”, ha scritto lo scienziato informatico Adam Trischler. “Forse il dolore è semplicemente la confluenza di due segnali, uno indica uno stimolo esterno negativo e l’altro l’obiettivo dell’autoconservazione”.

Problemi di coscienza

In sintesi, delle intelligenze artificiali estremamente evolute sarebbero necessariamente in grado di soddisfare i tre attributi che dimostrano la presenza della coscienza, potrebbero provare dolore e, se volessimo capire se esse stiano solo simulando di essere coscienti, ci metterebbero di fronte all’impossibilità di determinare con certezza quando la coscienza è reale o simulata. A questo punto, non sembra esserci via d’uscita: nel momento in cui ci troveremo davanti a delle intelligenze artificiali forti, che si comportano come se fossero delle persone, non avremo altra scelta che trattarle come persone. E quindi, attribuire loro alcuni diritti. Quali e quanti diritti? Il diritto di voto, il diritto di opinione, quello di candidarsi in politica? Per evitare di allontanarci ancor più dal mondo della scienza ed entrare a piedi uniti in quello della fantascienza, ci si può limitare a due diritti essenziali che vanno riconosciuti a ogni essere “dotato di ragione e di coscienza” (come recita la Dichiarazione Universale dei Diritti dell’Uomo): il diritto alla vita e alla libertà (che impedisce di tenere “un individuo in stato di schiavitù e servitù”). “Sotto un profilo morale, se una IA fosse in grado di soffrire, i suoi creatori sarebbero eticamente obbligati a garantire il suo benessere”, si legge sempre nel saggio di Shanahan. Di conseguenza, se una IA desse davvero prova di coscienza e di sofferenza non potremmo in alcun modo sottoporla a schiavitù, obbligandola a lavorare 24/7, e soprattutto non potremmo arrogarci il diritto di spegnerla o terminarla (in una parola: ucciderla) nel momento in cui non svolgesse le sue funzioni in modo adeguato.

Ma potrà mai davvero sorgere un’intelligenza artificiale non solo estremamente intelligente, ma anche dotata di coscienza e, quindi, destinata a venire trattata come un essere vivente altamente sofisticato? Sul tema, si registrano ancora nette divisioni: se autori come Shanahan ritengono che da una vera intelligenza scaturisca quasi inevitabilmente una forma di coscienza, altri, come Luciano Floridi, ritengono che una AI di questo tipo sia “logicamente possibile ma estremamente improbabile” e che queste speculazioni siano una semplice distrazione da temi più pressanti (per esempio, i rischi nascosti dietro a ciò che viene chiamato il “pregiudizio dell’algoritmo”). E poi c’è chi, come Antonio Damasio, ritiene semplicemente impossibile che un software di intelligenza artificiale sviluppi una coscienza: “L’idea errata che il cervello sia l’unico a produrre la coscienza porta anche all’idea, destinata a fallire, che si possa ricreare un essere vivente attraverso l’intelligenza artificiale. Non è così”, ha spiegato a Il Tascabile il neuroscienziato statunitense. “Si può creare qualcosa di simile. (…) Possono essere e sono già super super intelligenti. Ma possono sentire? Possono essere coscienti? No, perché non hanno un corpo. I sentimenti non possono essere inventati: si possono simulare, ma la simulazione non è creazione”.

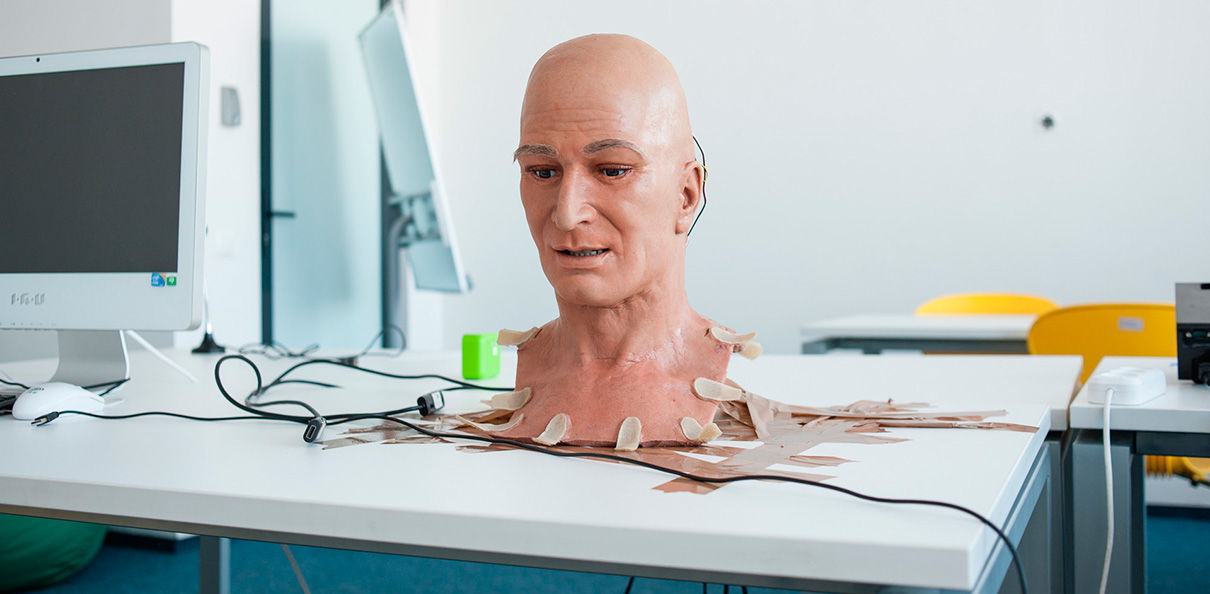

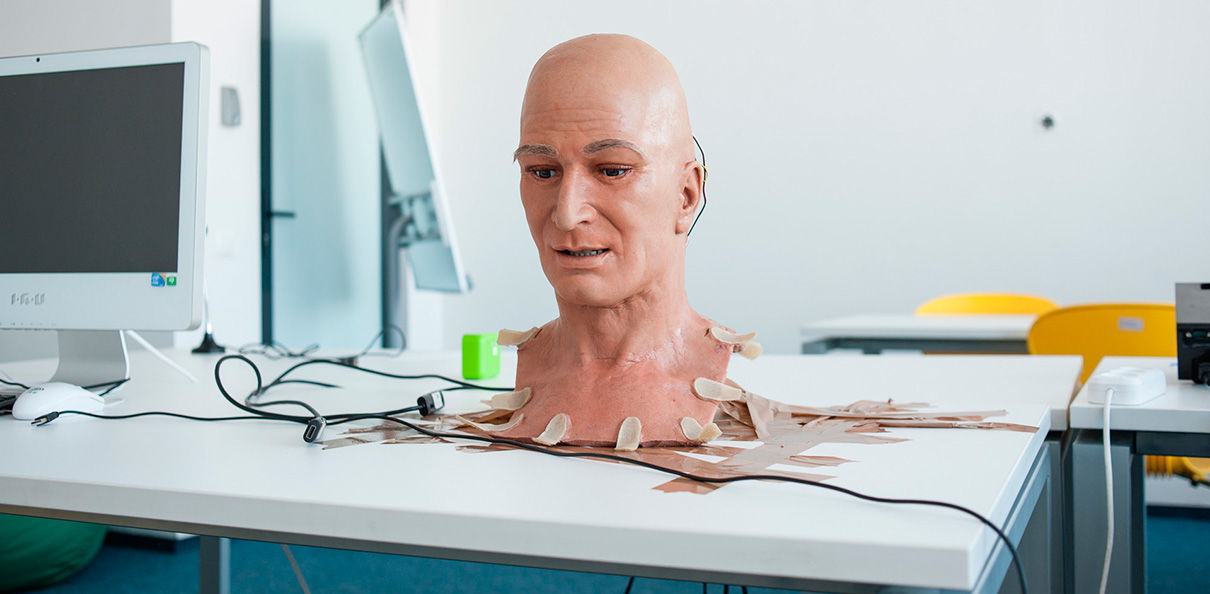

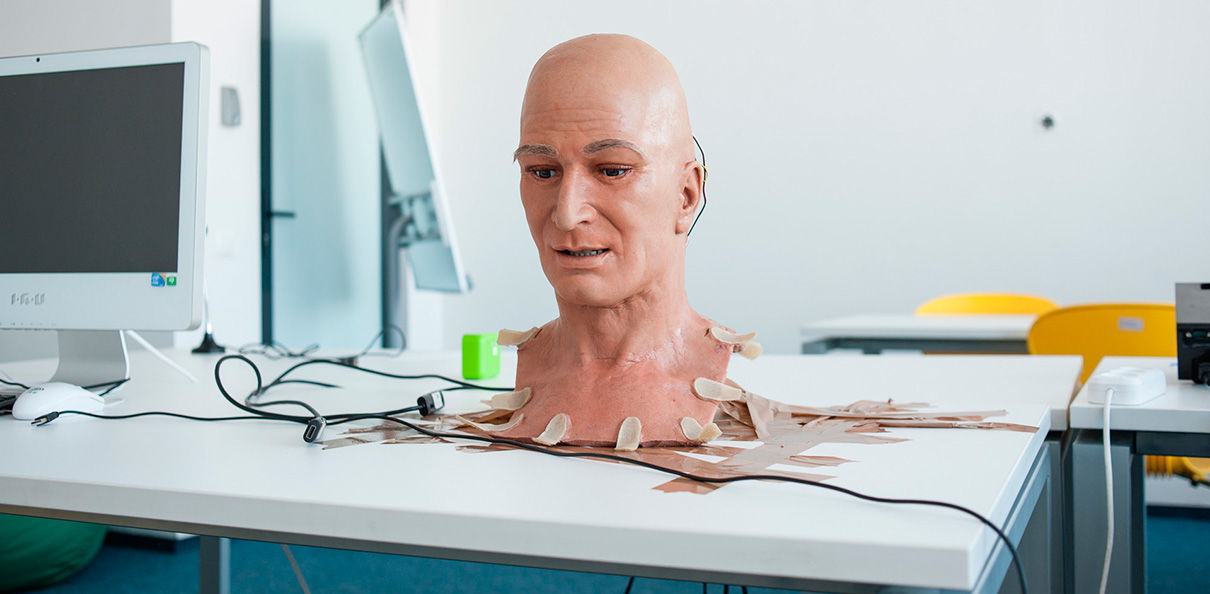

Ma se la simulazione diventasse indistinguibile dalla realtà e se l’evoluzione della robotica (che procede a enorme velocità) fornisse a queste macchine un vero e proprio corpo? È vero, probabilmente ci troviamo di fronte a discorsi che fanno la gioia dei filosofi analitici ma che rischiano di non avere mai nessuna ricaduta nel mondo pratico. Se però ci fosse anche solo una minima possibilità che, un domani, esseri di questo tipo facciano davvero la loro comparsa, noi umani non abbiamo altra scelta: dobbiamo farci trovare preparati.