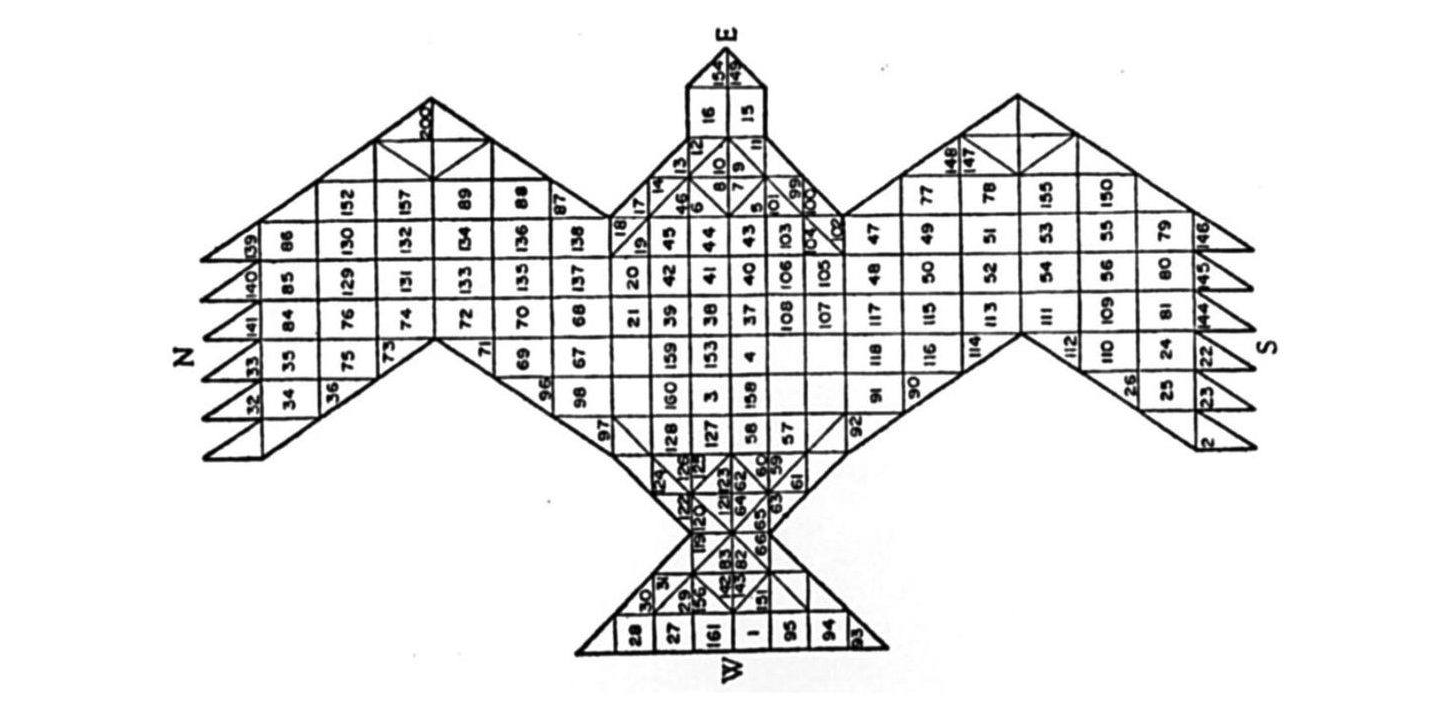

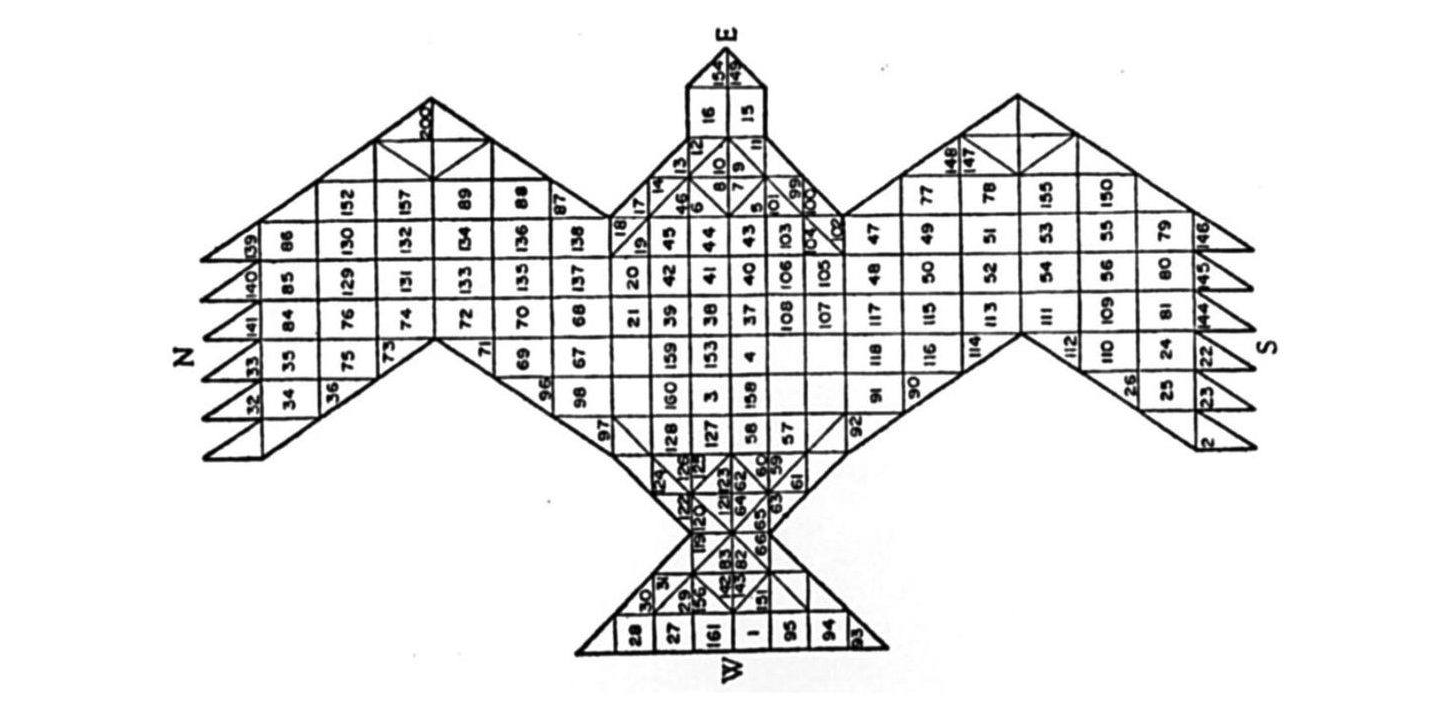

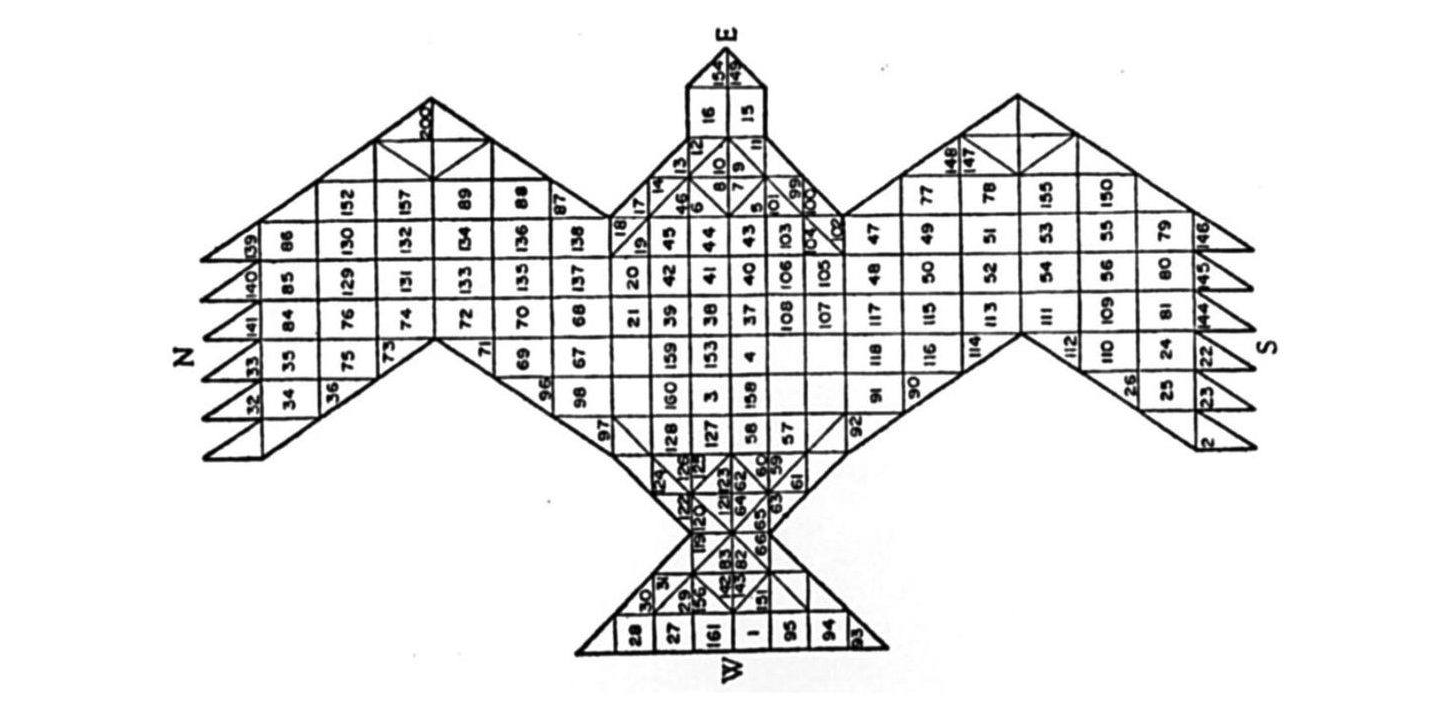

I n un affascinante mito cosmogonico degli antichi Veda, si narra che, nell’atto di creazione dell’universo, lo stesso dio creatore Prajapati venisse distrutto. In seguito alla nascita del mondo, la divinità suprema fu ritrovata a pezzi, smembrata. Nel corrispettivo rito Agnicayana, i devoti induisti ricompongono simbolicamente i frammenti del corpo del dio edificando un altare di fuoco secondo un complesso piano geometrico. L’altare è costruito allineando migliaia di mattoni dalle forme e dimensioni precise, in modo da creare il profilo di un falco. Ciascun mattone è numerato e collocato recitando un mantra dedicato e seguendo passo a passo le istruzioni. Ogni strato dell’altare è costruito sopra il precedente rispettandone la stessa area e forma. Risolvendo un rompicapo logico che è la chiave del rituale, ogni strato deve mantenere la stessa forma e area di quello contiguo, usando però una configurazione di mattoni diversa. Infine, l’altare a forma di falco deve essere orientato verso est, preludio al volo simbolico del dio verso il sole che sorge – esempio di reincarnazione divina per via geometrica.

Il rituale Agnicayana è descritto nelle Shulba Sutras, scritte in India intorno all’800 a.C., ma che documentano una tradizione orale molto più antica. Le Shulba Sutras insegnano la costruzione di altari di specifiche forme geometriche per assicurarsi doni dalle divinità. Per esempio, suggeriscono che “coloro che desiderano distruggere nemici presenti e futuri dovrebbero costruire altari per il fuoco a forma di rombo”. La complessa forma di falco dell’Agnicayana si è sviluppata gradualmente da una composizione schematica di soli sette quadrati. Nella tradizione Vedica si dice che gli spiriti vitali Rishi crearono sette Purusha (entità cosmiche o persone) di forma quadrata che insieme componevano un unico corpo, ed era da questa forma che Prajapati emergeva nuovamente. Nel 1907 lo storico dell’arte Wilhelm Worringer suggerì che l’arte primitiva fosse nata nelle linee astratte dei graffiti rupestri; allo stesso modo si potrebbe presumere che il gesto artistico sia emerso anche attraverso la composizione di segmenti e frazioni, introducendo forme e tecniche geometriche di complessità sempre maggiore. Nei suoi studi sulla matematica vedica, il matematico italiano Paolo Zellini ha scoperto che il rito Agnicayana era utilizzato per trasmettere tecniche di approssimazione geometrica o crescita incrementale – in altre parole, tecniche algoritmiche – paragonabili ai calcoli moderni di Leibniz e Newton. L’Agnicayana è uno tra i più antichi riti documentati ancora oggi praticati in India e un esempio primordiale di cultura algoritmica.

Ma come possiamo definire algoritmico un rito antico quanto l’Agnicayana? Per molti leggere le culture del passato attraverso il paradigma delle più recenti tecnologie potrebbe apparire come un atto di appropriazione culturale. Ciononostante, affermare che le tecniche astratte della conoscenza e i metalinguaggi artificiali appartengano unicamente al moderno Occidente industrializzato non è solo storicamente inaccurato, ma è anche un atto di colonialismo epistemico verso culture di altri luoghi e tempi. Il matematico francese Jean-Luc Chabert ha notato che “gli algoritmi esistono dall’inizio dei tempi, molto prima che fosse coniata una parola specifica per descriverli. Gli algoritmi sono semplicemente un insieme di istruzioni da svolgere passo dopo passo, da eseguire quasi meccanicamente per raggiungere determinati risultati”. Oggi sono in molti a considerare gli algoritmi come una recente innovazione tecnologica che implementa principi matematici e astratti. Al contrario, gli algoritmi sono tra le pratiche più antiche e materiali dell’umanità e, in quanto tali, hanno anticipato molti strumenti e tutte le macchine moderne:

Gli algoritmi non sono circoscritti solo al campo della matematica […]. I Babilonesi li usavano per stabilire i principi della legge, i maestri latini per ottenere una grammatica corretta, e sono stati utilizzati in tutte le culture per predire il futuro, per decidere trattamenti medici o per preparare il cibo […] parliamo quindi di ricette, regole, tecniche, processi, procedure, metodi, ecc., usando la stessa parola applicata a diverse situazioni. I cinesi, per esempio, usano la parola shu (con il significato di regola, processo o stratagemma) sia per la matematica che per le arti marziali […]. Alla fine, il termine algoritmo è arrivato ad indicare qualsiasi processo di calcolo sistematico, cioè un processo che può essere eseguito automaticamente. Oggi, soprattutto grazie all’influenza dell’informatica, l’idea di finitezza è diventata un elemento essenziale nel definire il significato di algoritmo, distinguendolo da nozioni più vaghe come processo, metodo o tecnica.

Ben prima del consolidamento della matematica e della geometria, le civiltà antiche erano già grandi macchine di segmentazione sociale che segnavano i corpi umani e i territori con astrazioni che sono rimaste e continueranno a rimanere operative per millenni. Facendo anche riferimento al lavoro dello storico Lewis Mumford, Gilles Deleuze e Félix Guattari hanno offerto una lista di queste antiche tecniche di astrazione e segmentazione sociale: “tatuare, praticare escissioni, incisioni, intagliare, scarificare, mutilare, scalfire, iniziare”. I numeri erano già elementi delle “macchine astratte primitive” della segmentazione sociale e della territorializzazione che avrebbero fatto emergere la civiltà umana: il primo censo documentato, per esempio, ha avuto luogo in Mesopotamia nel 3800 a.C. circa. Forme logiche costituite da forme sociali, i numeri si modellarono attraverso il lavoro e i rituali, la disciplina e il potere, l’iscrizione dei corpi e la ripetizione.

Negli anni Settanta, il nuovo campo dell’“etnomatematica” ha consumato una prima rottura con il platonismo della matematica d’élite, rivelando i soggetti storici che si celano dietro ogni calcolo che appare astratto. La questione politica al centro del corrente dibattito sulla computazione e sulla politica degli algoritmi è in definitiva molto semplice, come Diane Nelson ci ricorda: Chi è che conta? Chi è che calcola? Algoritmi e macchine non eseguono calcoli per sé stessi; lo fanno sempre per altri, per istituzioni e mercati, per industrie ed eserciti.

neurodynamics. Perceptrons and the theory of brain mechanisms.

Cos’è un algoritmo?

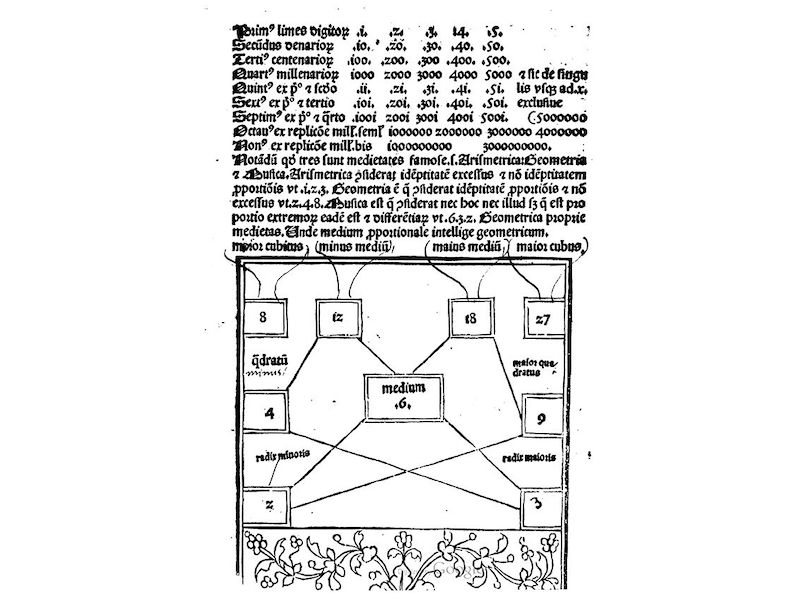

Il termine “algoritmo” viene dalla latinizzazione del nome dello studioso persiano al-Khwarizmi. Al suo trattato Algoritmi de numero indorum, scritto a Baghdad nel Nono secolo, si deve l’introduzione dei numeri indo-arabi in Occidente e delle nuove tecniche per calcolarli, chiamate appunto algoritmi. La parola medievale latina algorismus si riferiva già alle procedure e metodi rapidi per svolgere le operazioni matematiche fondamentali – addizione, sottrazione, moltiplicazione e divisione – con i numeri indo-arabi. Più tardi, il termine algoritmo venne applicato ad altre procedure logiche fino a diventare l’elemento centrale dell’informatica. In generale, possiamo distinguere tre stadi nell’evoluzione degli algoritmi: nell’Antichità si trovano di fatto forme algoritmiche in procedure e rituali codificati per raggiungere uno scopo, risolvere un problema pratico o trasmettere delle regole; nel Medioevo algoritmo era il nome dato a una procedura adottata per svolgere operazioni matematiche; in Età moderna l’algoritmo – inteso come procedura logica altamente formalizzata – viene prima automatizzato da macchine e in seguito da computer digitali.

Osservando le antiche pratiche rituali come l’Agnicayana e le regole di calcolo della matematica indiana, si può delineare una definizione elementare di algoritmo che sia compatibile con l’informatica moderna: (1) l’algoritmo è un diagramma astratto che emerge dalla ripetizione di un processo, da un’organizzazione del tempo, dello spazio, del lavoro e delle operazioni – non è una regola inventata dall’alto ma sviluppata dal basso; (2) l’algoritmo è la divisione di questo processo in un numero finito di fasi finalizzata alla ripetizione e al controllo efficiente dello stesso; (3) l’algoritmo è la soluzione ad un problema, un’invenzione che progredisce oltre le costrizioni di una situazione – ogni algoritmo è un trucco, un esperimento; (4) un aspetto ancora più significativo consiste nel fatto che l’algoritmo è un processo economico, poiché deve utilizzare il minor numero possibile di risorse in termini di spazio, tempo ed energia, adattandosi ai limiti della situazione.

Oggi, con le crescenti capacità dell’intelligenza artificiale, c’è la tendenza a percepire gli algoritmi come un’applicazione di un’idea matematica astratta su dati concreti. Al contrario, la genealogia dell’algoritmo dimostra che la sua forma si è sviluppata a partire da pratiche materiali, da una divisione mondana dello spazio, del tempo, del lavoro e delle relazioni sociali. Le procedure rituali, le routine sociali e l’organizzazione dello spazio e del tempo sono all’origine degli algoritmi e, in questo senso, si può dire che siano esistiti anche prima della nascita di complessi sistemi culturali come la mitologia, la religione e, soprattutto, il linguaggio. In termini di antropogenesi, sono i processi algoritmici codificati nelle pratiche sociali e nei rituali a far emergere numeri e tecnologie numeriche, e non viceversa. La moderna informatica, se si guarda anche alla sua genealogia industriale nelle fabbriche studiate da Charles Babbage e Karl Marx, si è evoluta gradualmente a partire da forme semplici di divisione del lavoro verso forme sempre più complesse ed astratte.

L’ascesa del machine learning come spazio computazionale

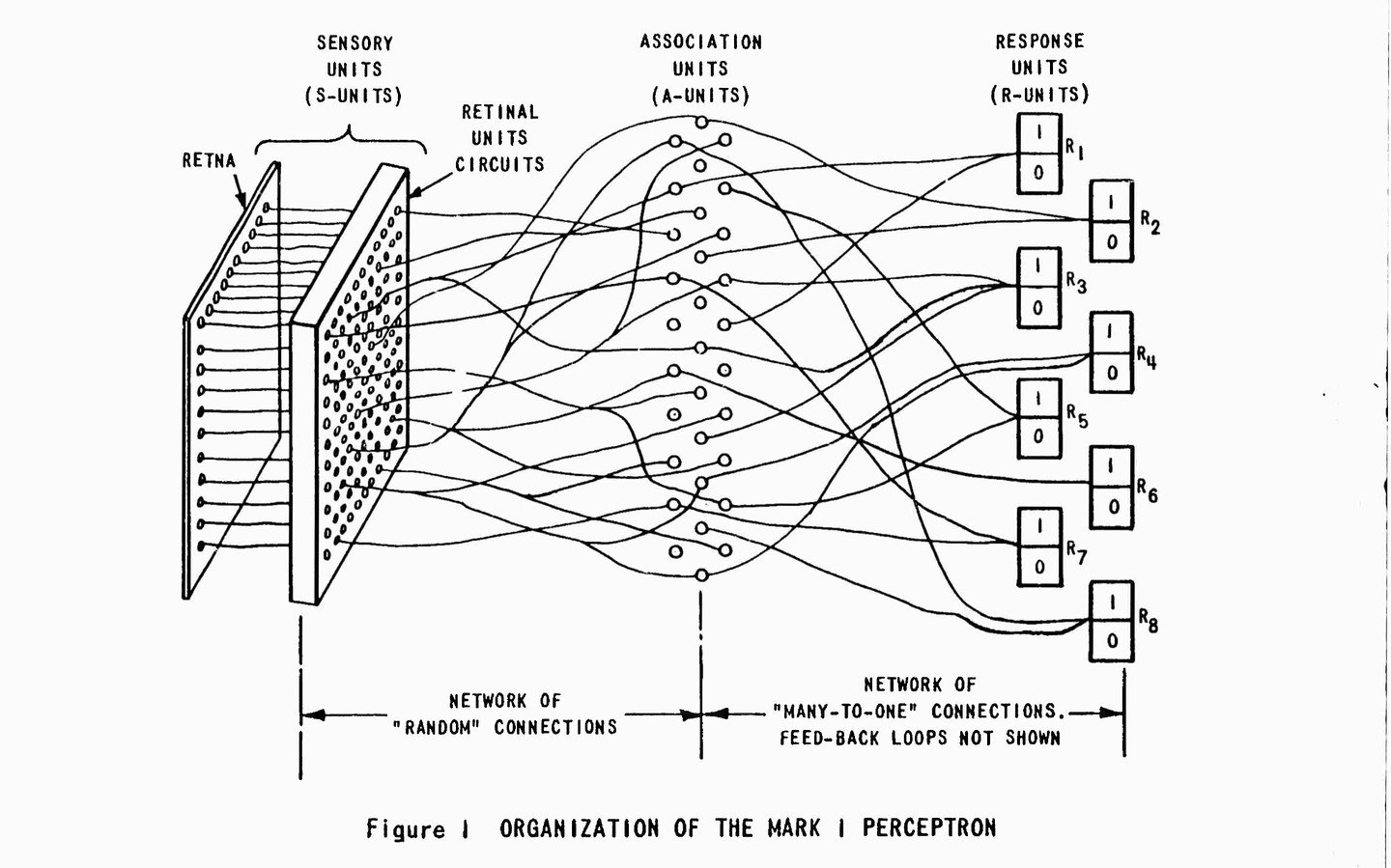

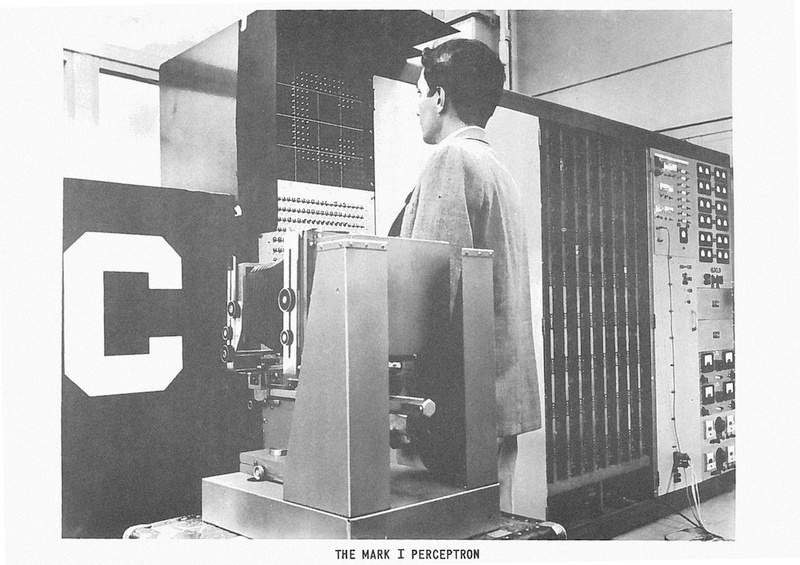

Nel 1957, presso il Cornell Aeronautical Laboratory di Buffalo (USA), lo studioso di scienze cognitive Frank Rosenblatt inventò e costruì il Perceptron, la prima rete neurale artificiale operativa – una matrice di calcolo che si può considerare la capostipite di tutte le matrici dell’apprendimento macchina.

Il primo prototipo del Perceptron era un computer analogico composto da un dispositivo di input di 20×20 fotocellule (chiamato “retina”), connesso con dei fili a uno strato di neuroni artificiali indirizzati verso un singolo output (una lampadina che si accendeva e si spegneva per indicare i valori 0 e 1). La retina del Perceptron registrava forme semplici come lettere e triangoli, e trasmetteva segnali elettronici a una moltitudine di neuroni che avrebbero calcolato i risultati sulla base di una logica a soglia. Il Perceptron era una specie di fotocamera che poteva essere istruita a prendere una decisione – con un consistente margine di errore – come ad esempio riconoscere una forma visuale (per questo motivo era definita una macchina “intelligente”). Il Perceptron può essere considerato il primo algoritmo di machine learning, un semplice “classificatore binario” in grado di determinare se un pattern sia parte o no di una specifica classe. Per raggiungere questo obiettivo, si adattavano progressivamente i valori dei nodi del Perceptron per risolvere l’input numerico (una matrice spaziale di quattrocento numeri) in un semplice output binario (0 o 1). Il Perceptron dava 1 come risultato se l’immagine era riconosciuta entro una specifica classe (un triangolo per esempio); altrimenti il risultato era 0. Inizialmente era necessario l’intervento di un operatore umano per far apprendere al Perceptron le risposte corrette, con la speranza che la macchina, sulla base di queste associazioni (imposte dall’operatore umano), potesse in futuro riconoscere correttamente forme simili.

La matrice di 20×20 fotocellule del primo Perceptron diede inizio ad una silenziosa rivoluzione computazionale – che, all’inizio del Ventunesimo secolo, sarebbe diventata paradigma egemonico con l’avvento del deep learning, una tecnica di machine learning. Sebbene ispirato ai neuroni biologici, da un punto di vista strettamente logico il Perceptron segnò una svolta topologica, e non biomorfica, della computazione: esso sancì l’ascesa del paradigma dello “spazio computazionale”, o “spazio di auto-computazione”. Ciò introdusse una seconda dimensione spaziale nel paradigma della computazione, che fino ad allora aveva avuto solo una dimensione lineare (si veda la macchina di Turing, che legge e scrive 0 e 1 lungo un nastro di memoria lineare). Questa svolta topologica, cruciale per ciò che oggi le persone percepiscono come “intelligenza artificiale”, può essere descritta più semplicemente come il passaggio da un paradigma a informazioni passive ad uno a informazioni attive. Invece che avere una matrice visiva elaborata da un algoritmo top-down (come avviene oggi alle immagini modificate dai software di grafica), nel Perceptron i pixel della matrice sono calcolati attraverso una modalità bottom-up a seconda della loro disposizione spaziale. Le relazioni spaziali dei dati visivi danno forma alle operazioni dell’algoritmo che le calcola.

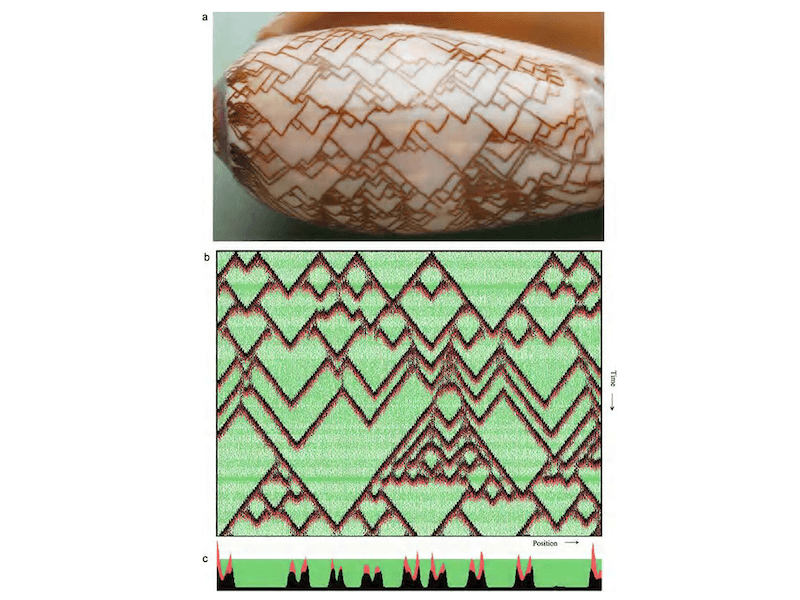

Il ramo dell’informatica in origine dedicato alle reti neurali era chiamato “geometria computazionale” proprio per la sua logica spaziale. Il paradigma dello spazio computazionale, o dello spazio di auto-computazione, condivide le stesse radici con gli studi dei principi di autorganizzazione al centro della cibernetica del secondo dopoguerra, come ad esempio gli automi cellulari di John von Neumann (1948) e il Rechnender Raum di Konrad Zuse (1967). Gli automi cellulari di von Neumann sono aggregati di pixel, percepiti come piccole cellule su una griglia, che cambiano stato e si muovono in base alle cellule adiacenti, componendo figure geometriche che ricordano forme di vita in evoluzione. Essi sono stati usati per simulare l’evoluzione e lo studio della complessità all’interno dei sistemi biologici, ma sono comunque automi a stati finiti confinati all’interno di un universo piuttosto limitato. Konrad Zuse, che costruì il primo computer programmabile a Berlino nel 1938, ha cercato di estendere la logica dell’automa cellulare alla fisica e all’intero universo. La sua idea di Rechnender Raum, o “spazio calcolante”, descrive un universo composto di unità discrete che agiscono sulla base del comportamento delle unità vicine. L’ultimo saggio di Alan Turing, La base chimica della morfogenesi (pubblicato nel 1952, due anni prima della sua morte), appartiene alla tradizione delle strutture di autonomic computing. Turing considerava le molecole dei sistemi biologici come agenti auto-computazionali in grado di interpretare complesse strutture bottom-up: i pattern dei tentacoli dell’idra, la disposizione a spirale delle piante, la gastrulazione degli embrioni, la screziatura nella pelle degli animali e la fillotassi dei fiori.

Gli automi cellulari di von Neumann e lo spazio calcolante di Zuse sono intuitivamente facili da comprendere come modelli spaziali, mentre la rete neurale di Rosenblatt è più complessa e richiede uno sguardo più approfondito. In effetti, le reti neurali utilizzano una struttura combinatoria molto articolata che, probabilmente, li rende gli algoritmi più efficienti per il machine learning. Si dice che le reti neurali siano in grado di “risolvere ogni problema”, che riescano cioè ad approssimare la funzione di ogni pattern secondo il teorema di approssimazione universale, a patto che siano forniti sufficienti strati di neuroni e di risorse computazionali. Tutti i sistemi di machine learning, come le macchine a vettori di supporto, le catene di Markov, le reti di Hopfield, le macchine di Boltzmann e le reti neurali convoluzionali, per nominarne solo alcuni, sono nati come modelli di geometria computazionale. In questo senso fanno parte dell’antica tradizione dell’ars combinatoria.

L’automazione del lavoro visivo

Alla fine del Ventesimo secolo non si sarebbe mai pensato di definire un camionista un “lavoratore cognitivo”, un intellettuale. All’inizio del Ventunesimo secolo l’utilizzo del machine learning per lo sviluppo di vetture autonome ha portato a un nuovo modo di concepire il lavoro manuale, come ad esempio la guida. Esso ha dimostrato che l’elemento centrale di qualsiasi lavoro non è mai solamente manuale, ma comprende anche una componente sociale e cognitiva (e anche percettiva, un aspetto che oscilla tra il manuale e il cognitivo). Che tipo di lavoro svolgono gli automobilisti? Quali attività umane verranno registrate dai sensori dell’intelligenza artificiale, imitate dai suoi modelli statistici e sostituite dall’automazione? Il miglior modo per rispondere a questa domanda è osservare sia ciò che la tecnologia è riuscita ad automatizzare con successo, che i suoi fallimenti.

Il progetto industriale di automatizzazione della guida ha dimostrato (molto più di quanto lo abbiano fatto migliaia di libri di economia politica) che guidare è un’attività conscia che segue regole codificate e convenzioni sociali spontanee. Tuttavia, la traduzione della guida in un algoritmo sembra possibile grazie alla sua struttura logica e inferenziale. Guidare è un’attività logica così come lo è il lavoro in generale. Questo postulato aiuta a risolvere la trita disputa sulla separazione tra il lavoro manuale e il lavoro intellettuale. Lo sviluppo aziendale di algoritmi AI per l’automazione ha permesso di riconoscere una componente cognitiva nel lavoro manuale a lungo trascurata dalla teoria critica – un paradosso politico. La relazione tra lavoro e logica diventa così una questione filosofica cruciale per l’età delle intelligenze artificiali.

Una self-driving car automatizza tutte le micro-decisioni che un autista deve compiere in una strada trafficata. Le reti neurali artificiali imparano a prendere decisione etiche quando si presenta un pericolo – per la sicurezza delle persone all’interno o all’esterno del veicolo – sostanzialmente imitando e copiando le correlazioni umane tra percezione visiva dello spazio stradale e gesti meccanici a controllo del veicolo (sterzo, accelerazione, arresto). Diventa chiaro che il lavoro degli automobilisti richiede enormi abilità cognitive che non possono essere lasciate all’improvvisazione e all’istinto. Ma è altresì evidente che l’abilità di prendere decisioni e risolvere problemi velocemente deriva da abitudini e da un allenamento non completamente consci. In fondo, guidare è un’attività anche sociale, che segue sia regole codificate (a livello legislativo) che regole spontanee – inclusi i “codici culturali” taciti ma a cui ogni conducente si attiene. Guidare a Mumbai, lo si sente spesso, non è la stessa cosa che guidare ad Oslo.

La guida richiede indubbiamente un intenso lavoro di percezione. Infatti, gran parte dell’attività svolta è di natura percettiva, ed è costellata da continue e improvvise azioni e decisioni cognitive. Non si può separare completamente la cognizione dalla logica spaziale, che anzi ritroviamo spesso anche nelle costruzioni cognitive più astratte. Entrambe le osservazioni – che la percezione è logica e che la cognizione è spaziale – sono verificate empiricamente e senza clamore dagli algoritmi AI impiegati nelle vetture autonome. Essi costruiscono dei modelli per rappresentare statisticamente lo spazio visivo (modelli codificati come video digitali di uno scenario stradale 3D). Non solo: il guidatore, sostituito dalle AI nelle vetture autonome e nei droni, non è più un singolo autista, ma un operatore collettivo, un cervello sociale che naviga la città e il mondo. Basta osservare il progetto aziendale di una vettura autonoma per accorgersi che l’AI è costruita a partire da dati collettivi che codificano una produzione collettiva dello spazio, del tempo, del lavoro e delle relazioni sociali. Le AI imitano, sostituiscono ed emergono proprio a partire da una divisione organizzata dello spazio sociale (secondo un algoritmo materiale e non mediante formule matematiche o analisi astratte).

La memoria e l’intelligenza dello spazio

Paul Virilio, il filosofo francese della velocità o “dromologia”, era anche un teorico dello spazio e della topologia, poiché era a conoscenza del fatto che la tecnologia accelera la percezione dello spazio tanto quanto cambia quella del tempo. Curiosamente il titolo del libro di Virilio The vision machine fu ispirato al Perceptron di Rosenblatt. Con la tipica erudizione del pensatore del Ventesimo secolo, Virilio ha tracciato una netta linea di demarcazione tra le antiche tecniche di memorizzazione basate sulla spazializzazione, come ad esempio la tecnica dei loci, e le moderne memorie dei computer a matrice spaziale:

Cicerone e gli antichi teorici della memoria credevano che fosse possibile consolidare la memoria naturale con l’aiuto di un addestramento appropriato. Avevano inventato un metodo topografico che consisteva nel reperire una serie di luoghi, di localizzazioni che potessero essere facilmente ordinati nel tempo e nello spazio. Possiamo immaginarci per esempio di spostarci nella nostra casa e scegliere come localizzazioni i tavoli, una sedia che vediamo in una stanza, o un davanzale, o una macchia sul muro. Poi si codifica in immagini ben definite il materiale da tenere in mente, e si sostituisce ogni immagine con localizzazioni precedentemente definite. Se vogliamo ricordarci un discorso, ne trasformiamo i punti principali in immagini concrete e “piazziamo” mentalmente ognuno di questi punti nelle diverse localizzazioni. Quando vorremo ricordare o pronunciare il discorso, basterà ricordare nell’ordine i luoghi della casa.

La trasformazione dello spazio, delle coordinate topologiche e delle proporzioni geometriche in una tecnica mnemonica dovrebbe essere valutata al pari delle più recenti trasformazioni dello spazio collettivo in una risorsa per l’intelligenza artificiale. Alla fine del suo libro, Virilio riflette sul ruolo delle immagini nell’epoca delle vision machines, di cui il Perceptron è un esempio. Il filosofo francese ci mette in guardia dall’imminente incombere di un’era dell’intelligenza artificiale, che consisterà in una sostanziale “industrializzazione della visione”:

“Ora gli oggetti mi guardano”, scriveva il pittore Paul Klee nei suoi Quaderni. Tale affermazione quantomeno sorprendente diventa, da poco tempo, oggettiva, veritiera. Non si parla forse della prossima produzione di una “macchina che vede” capace non solo di riconoscere i contorni delle forme, ma anche di interpretare completamente il campo visivo […]? Non si parla forse anche di una nuova disciplina tecnica, la “visionica”, ossia la possibilità di ottenere una visione senza sguardo in cui la videocamera dipenderebbe da un computer […] e ciò nel campo della produzione industriale, della gestione di stock, o anche in quello della robotica militare?Così, nel momento in cui si prepara l’automazione della percezione, l’innovazione di una visione artificiale, la delega alla macchina dell’analisi della realtà oggettiva, è opportuno riconsiderare la natura dell’immagine virtuale […]. In effetti al giorno d’oggi non si può parlare di sviluppo dell’audiovisivo […] senza annunciare la nuova industrializzazione della visione, l’approntamento di un vero e proprio mercato della percezione sintetica, con tutti i problemi etici che ne derivano […]. Non dimentichiamo che il Perceptron viene messo in funzione per favorire l’emergenza di “sistemi aperti” della quinta generazione, ossia dell’intelligenza artificiale che ormai può arricchirsi soltanto con l’acquisizione di nuovi organi di percezione.

Conclusioni

Consideriamo l’antica geometria dei rituali Agnicayana, la matrice computazionale della prima rete neurale Perceptron e il complesso sistema di navigazione dei veicoli autonomi. L’insieme di queste diverse logiche spaziali può forse aiutarci a capire che l’algoritmo è una forma emergente piuttosto che un a priori tecnologico. I rituali Agnicayana sono un esempio di algoritmo emergente che codifica l’organizzazione di uno spazio sociale e rituale. La loro funzione simbolica è la ricostruzione della divinità attraverso strumenti terreni; questa pratica simboleggia anche l’espressione della molteplicità nell’Uno (o la “computazione” dell’Uno attraverso i molti). La funzione sociale è invece quella di insegnare delle competenze matematiche elementari e la costruzione di edifici. Il rituale Agnicayana è una forma di pensiero algoritmico che segue la logica di una geometria computazionale semplice e primordiale.

Anche il Perceptron è un algoritmo emergente che codifica a seconda della divisione dello spazio e, nello specifico, della matrice spaziale dei dati visivi. La matrice dei fotorecettori del Perceptron definisce un campo limitato ed elabora un algoritmo che calcola i dati in base alla loro relazione spaziale. Anche in questo caso l’algoritmo appare come un processo emergente – la codificazione e cristallizzazione di una procedura, di un pattern, dopo la sua ripetizione. Tutti gli algoritmi del machine learning sono processi emergenti, in cui la ripetizione di pattern simili “insegna” alla macchina e fa sì che un pattern affiori come una distribuzione statistica.

I veicoli autonomi sono un esempio di algoritmi complessi che si costituiscono da una costruzione dello spazio piuttosto articolata – l’ambiente stradale in quanto istituzione sociale costruita dal codice della strada e da regole spontanee. Gli algoritmi delle vetture autonome, dopo aver registrato le norme e i codici di una data località, provano a predire eventi inaspettati che potrebbero accadere in una strada trafficata. In questo caso, l’utopia produttiva dell’automazione cancella l’autista umano nella speranza che sia lo spazio visivo dello scenario stradale a determinare come la mappa verrà navigata.

I tre esempi sopra descritti sono tutti, in modi diversi, forme di spazio auto-calcolato e algoritmi emergenti (e probabilmente anche forme di invisibilizzazione del lavoro). In particolare, l’idea di uno spazio di calcolo o di spazio auto-calcolato indica che gli algoritmi del machine learning e dell’intelligenza artificiale sono sistemi emergenti fondati su una divisione terrena e materiale dello spazio, del tempo, del lavoro e delle relazioni sociali. Il machine learning si sviluppa a partire da alcune coordinate che si rifanno ad antiche astrazioni e rituali, e che riguardano la demarcazione del territorio e dei corpi, il computo delle persone e delle divinità. In altre parole, il machine learning emerge essenzialmente dalla divisione estesa del lavoro sociale. Nonostante le modalità con cui viene solitamente raffigurata e problematizzata, l’intelligenza artificiale non è realmente “artificiale” né “aliena”: nel processo di mistificazione dell’ideologia essa appare come il deus ex machina del teatro antico che trascende il mondo presente. Ma questo modo di concepirla nasconde la realtà dei fatti: essa emerge dall’intelligenza di questo mondo.

Ciò che le persone chiamano AI è in realtà un lungo processo storico di cristallizzazione di comportamenti collettivi, di dati personali e del lavoro individuale in algoritmi privatizzati che vengono usati per l’automazione di compiti complessi: dalla guida di una vettura alla traduzione un testo, dal riconoscimento di un oggetto alla composizione di un brano musicale. I macchinari industriali ebbero origine dalla sperimentazione, dalle competenze e dal lavoro di operai specializzati, ingegneri e artigiani. Allo stesso modo, i modelli statistici dell’AI si sono sviluppati a partire dai dati prodotti dall’intelligenza collettiva. Ciò significa che l’AI emerge come un enorme motore che imita l’intelligenza collettiva. Che relazione c’è tra l’AI e l’intelligenza umana? La divisione sociale del lavoro.

Estratto da AI & Conflicts, a cura di Francesco D’Abbraccio e Andrea Facchetti (krisis publishing, 2021).

Testo originariamente pubblicato su e-flux Journal 101 (giugno 2019).